Dans un contexte d’explosion des volumes de données d’entreprise, l'IA est à la pointe de révolutionner la ...

Les organisations s'appuient de plus en plus sur l'IA pour dégager des tendances, stimuler l'innovation et ...

Tout comme l'achat de biens en ligne implique de sélectionner des objets, les ajouter à un panier et de choisir ...

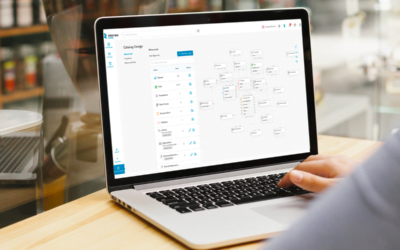

Au cours de la dernière décennie, les catalogues de données ont émergé en tant que piliers dans l’écosystème data. ...

Au cours de la dernière décennie, les catalogues de données ont émergé en tant que piliers dans l’écosystème data. ...

Au cours de la dernière décennie, les catalogues de données ont émergé en tant que piliers dans l’écosystème data. ...

Dans le paysage digital et data d'aujourd'hui, le partage de données ou Data Sharing, est devenu essentiel pour ...

Le Data Mesh est l'un des sujets les plus tendance dans l'espace data. En effet, selon une récente enquête ...

Au cours de la dernière décennie, les data catalogs ont émergé en tant que piliers dans l'écosystème data. ...

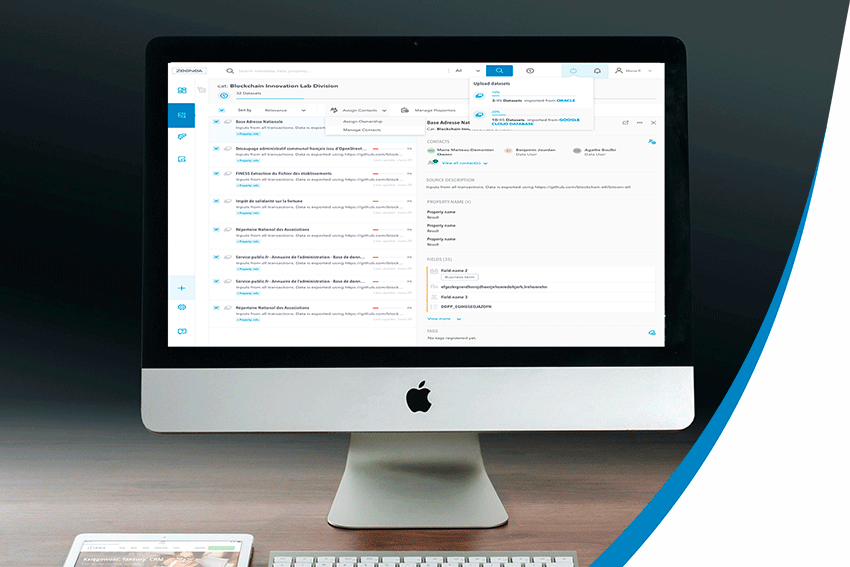

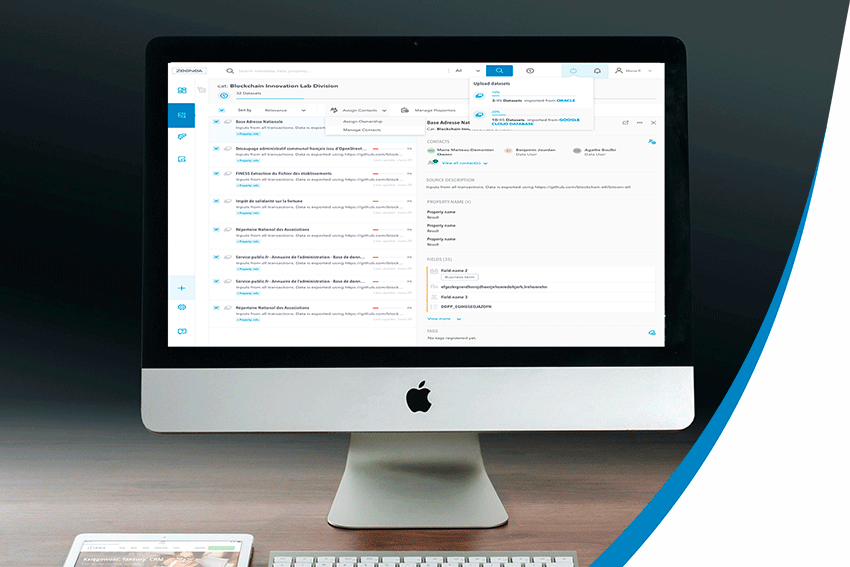

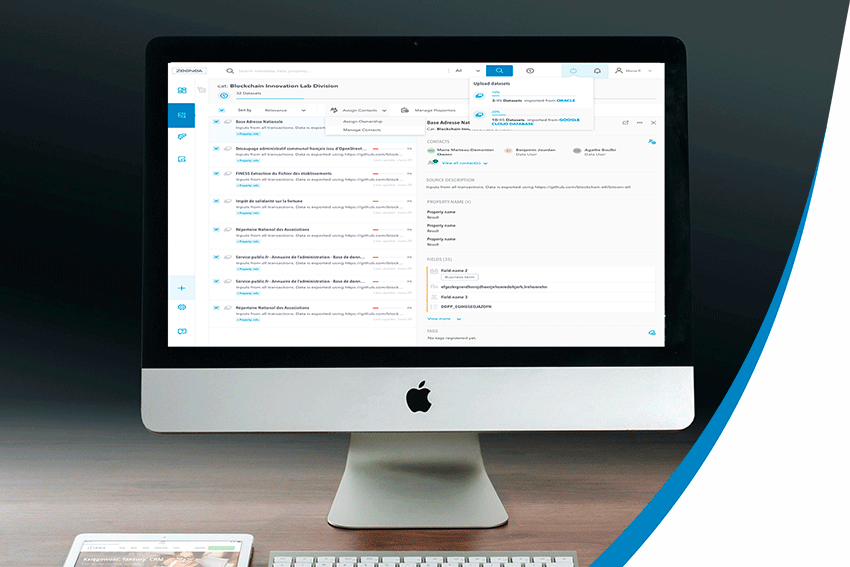

Paris, 23 janvier 2024 - Zeenea, leader dans la gestion des métadonnées et la découverte des données d'entreprise, ...

2023 a été une belle année pour Zeenea. Avec plus de 50 releases et mises à jour de notre plateforme, ces 12 ...

Chaque année, Zeenea organise des événements exclusifs qui rassemblent nos clients et partenaires de diverses ...

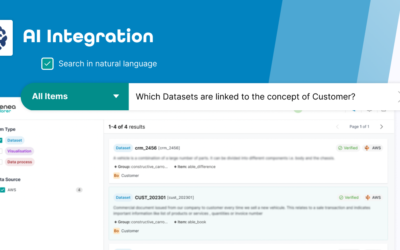

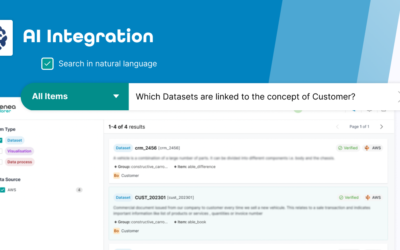

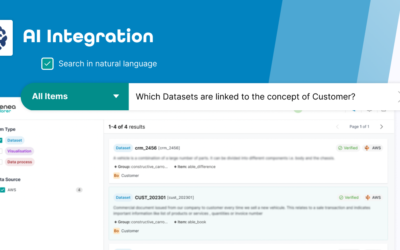

Zeenea est heureux d'annoncer l'intégration de capacités de recherche par traitement du langage naturel (NLP) ...

Vous avez mis la donnée au centre de toutes les stratégies de votre entreprise, mais le volume de données que vous ...

Vous nourrissez l’ambition de faire de votre organisation une entreprise data-driven ? Vous n’échapperez pas à la ...

Dans le monde d’aujourd’hui, les organisations de tous secteurs collectent d'énormes quantités de données ...

Vous vous réveillez avec le cœur qui bat à cent à l’heure. Vos pieds tremblent - Il y a quelques instants à peine, ...

Nous sommes ravis de soutenir le travail de l’institut de recherche BARC, et nous vous offrons la possibilité de ...

Vous traitez des données, énormément de données… Mais elles sont souvent désordonnées, incomplètes et surtout ...

Introduction : qu’est-ce que le data mesh?

Avec la prise de conscience de l’importance stratégique de la donnée ...

La gestion des métadonnées est une composante importante dans un projet plus global de Data Management, et elle ...

La gestion des métadonnées est une composante importante dans un projet plus global de Data Management, et elle ...

La gestion des métadonnées est une composante importante dans un projet plus global de Data Management, et elle ...

La gestion des métadonnées est une composante importante dans un projet plus global de Data Management, et elle ...

En déployant un programme de Data Stewardship dans votre entreprise, vous pourrez garantir non seulement la ...

Depuis le début du 21e siècle, nous vivons une véritable révolution numérique. Le monde est en constante ...

Pour rester compétitives, les organisations doivent prendre des décisions rapidement et la moindre erreur peut ...

Face à la recrudescence des cyber-menaces, chaque entreprise qui traite des données est soumise à une multitude de ...

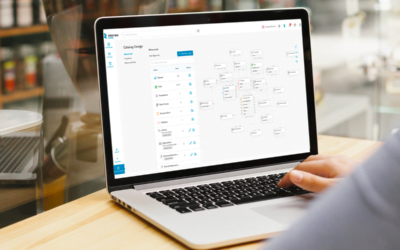

Un data catalog consolide des millions d’informations de nature très diverses - et ce volume croît de façon ...

Un data catalog consolide des millions d’informations de nature très diverses - et ce volume croît de façon ...

Un data catalog consolide des millions d’informations de nature très diverses - et ce volume croît de façon ...

Un data catalog consolide des millions d’informations de nature très diverses - et ce volume croît de façon ...

Un data catalog consolide des millions d’informations de nature très diverses - et ce volume croît de façon ...

Les entreprises manipulent des volumes gigantesques et toujours croissants d’assets techniques, avec généralement ...

Le 20 octobre dernier, BARC organisait un webinaire interactif réunissant trois acteurs historiques du marché ...

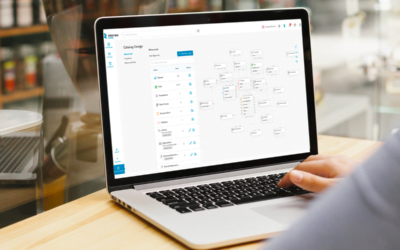

Le Data Catalog d’une organisation permet de valoriser l'ensemble de son patrimoine de données en s'appuyant ...

Dans notre précédent article, nous avons décomposé le Data Lineage en présentant les différentes typologies de ...

Le sujet de Data Lineage semble universel : quel que soit le secteur d’activité, toutes les parties prenantes ...

Vos actifs data doivent être accessibles et exploitables à tout moment, sans aucune interruption. Pour y ...

Votre entreprise produit ou exploite toujours plus de données ? Pour les classer, les ordonner, et les faire ...

Posséder d’importants volumes de données, c’est bien. Les exploiter au quotidien avec pragmatisme, intelligence ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Derrière les usages liés à la donnée on trouve régulièrement de nouveaux termes : Data Management Platform, Data ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Le marché du Data Catalog a beaucoup évolué depuis ses débuts, et ce composant est désormais identifié ...

Quel que soit le secteur d’activité, la maîtrise des données est un axe stratégique clé pour les entreprises. Ces ...

La transformation digitale est devenue une priorité dans la stratégie globale des entreprises et les industries ne ...

Enregistré le 20 novembre 2020, Sandrine Bernaud, Product Manager chez Zeenea, avait été invitée pour participer ...

Comment tirer parti d’un Machine Learning Data Catalog ?

Vous pouvez utiliser les data catalogs d'apprentissage ...

Depuis quelques années, les knowledge graphs nous entourent... Que ce soient par des expériences d'achat ...

Le terme "smart data catalog" est devenu tendance ces derniers mois. Cependant, lorsqu'on parle de quelque chose ...

Les data lakes offrent un stockage illimité pour les données et présentent de nombreux avantages pour les data ...

Les transformations digitales font émerger de nouveaux challenges autour de la data. Toutefois, le constat fait ...

Nous observons sur le marché des data catalogs de nombreuses solutions proposant une vue haut niveau des données ...

La Data est devenue l'un des principaux moteurs d’innovation dans de nombreux secteurs.Et comme les données ...

L’explosion des sources de données dans les entreprises, l'hétérogénéité des données ou encore les nouvelles ...

Dans la gestion de métadonnées, on entend souvent parler de “dictionnaires de données” et de “business ...

“Data is content, and metadata is context. Metadata can be much more revealing than data, especially when ...

Selon une étude Gartner présentée lors de la conférence Data & Analytics à Londres 2019, 90% ...

La machine peut-elle penser ? Nous parlons évidemment d’intelligence artificielle, le ...

Il est évident que les entreprises qui souhaitent tirer un maximum de profit des quantités pléthoriques ...

Pour la deuxième année consécutive, Zeenea a participé au Salon Big Data Paris en tant que ...

L’usage des données massives fait par les Grands du Web dans les années 2000 a été une ...

Le Data Steward est l’interlocuteur data de référence dans l’entreprise. Véritable chef d’orchestre, il ...

Un catalogue de données est un portail regroupant les métadonnées sur les jeux de données collectés par ...

L’arrivée du Big Data n’a simplifié en rien le travail effectué sur les données par les ...

Le data lineage est défini comme le cycle de vie des données : origine, transformations et ...

Le data lineage est défini comme le cycle de vie de la donnée. Il veut être une ...

![[SÉRIE] Data Shopping Partie 2 – L’expérience de Data Shopping dans Zeenea](https://zeenea.com/wp-content/uploads/2024/06/zeenea-data-shopping-experience-blog-image-400x250.png)

![[SÉRIE] La data marketplace pour le data mesh – Partie 3 : Alimenter la marketplace via des data catalogs par domaine](https://zeenea.com/wp-content/uploads/2024/06/iStock-1418478531-400x250.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 2 : Construire une marketplace à l’échelle de l’entreprise](https://zeenea.com/wp-content/uploads/2024/06/iStock-1513818710-400x250.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 1 : Faciliter la consommation des data products avec les métadonnées](https://zeenea.com/wp-content/uploads/2024/05/iStock-1485944683-400x250.jpg)

![[Communiqué de Presse] Zeenea lance son Enterprise Data Marketplace pour faciliter la gestion des Data Products](https://zeenea.com/wp-content/uploads/2024/01/lancement-enterprise-data-marketplace-400x250.png)

![[SÉRIE] Data Shopping Partie 2 – L’expérience de Data Shopping dans Zeenea](https://zeenea.com/wp-content/uploads/2024/06/zeenea-data-shopping-experience-blog-image-400x250.png)

![[SÉRIE] La data marketplace pour le data mesh – Partie 3 : Alimenter la marketplace via des data catalogs par domaine](https://zeenea.com/wp-content/uploads/2024/06/iStock-1418478531-400x250.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 2 : Construire une marketplace à l’échelle de l’entreprise](https://zeenea.com/wp-content/uploads/2024/06/iStock-1513818710-400x250.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 1 : Faciliter la consommation des data products avec les métadonnées](https://zeenea.com/wp-content/uploads/2024/05/iStock-1485944683-400x250.jpg)

![[Communiqué de Presse] Zeenea lance son Enterprise Data Marketplace pour faciliter la gestion des Data Products](https://zeenea.com/wp-content/uploads/2024/01/lancement-enterprise-data-marketplace-400x250.png)

![[SÉRIE] Data Shopping Partie 2 – L’expérience de Data Shopping dans Zeenea](https://zeenea.com/wp-content/uploads/2024/06/zeenea-data-shopping-experience-blog-image-400x250.png)

![[SÉRIE] La data marketplace pour le data mesh – Partie 3 : Alimenter la marketplace via des data catalogs par domaine](https://zeenea.com/wp-content/uploads/2024/06/iStock-1418478531-400x250.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 2 : Construire une marketplace à l’échelle de l’entreprise](https://zeenea.com/wp-content/uploads/2024/06/iStock-1513818710-400x250.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 1 : Faciliter la consommation des data products avec les métadonnées](https://zeenea.com/wp-content/uploads/2024/05/iStock-1485944683-400x250.jpg)

![[Communiqué de Presse] Zeenea lance son Enterprise Data Marketplace pour faciliter la gestion des Data Products](https://zeenea.com/wp-content/uploads/2024/01/lancement-enterprise-data-marketplace-400x250.png)