La qualité de la donnée, Data Quality en anglais, fait référence à la capacité d’une entreprise à maintenir la pérennité de ses données à travers le temps. À écouter certains professionnels de la qualité des données on peut avoir le sentiment qu’améliorer la qualité des données est la solution à tous les problèmes métiers – que cela devrait donc être une top priorité.

Chez Zeenea, la réalité est, selon nous, à nuancer : la Data Quality devrait être considérée uniquement comme un moyen parmi d’autres de réduire l’incertitude d’atteindre les objectifs de votre entreprise.

Dans cette série d’articles, nous vous livrerons tout ce que les professionnels des données doivent savoir sur la gestion de la qualité des données ou Data Quality Management (DQM) :

- Les neuf dimensions de la qualité de la donnée

- Les défis et risques liés à la qualité des données

- Les principales fonctionnalités d’un outil de DQM

- La contribution du Data Catalog au DQM

Qu’est-ce que la Data Quality

Si vous demandez à des Data Analysts ou des Data Engineers de définir ce qu’est la qualité de la donnée, vous aurez très probablement des réponses différentes – ce même au sein d’une même entreprise et pour le même type de profil. Certains vont par exemple parler d’unicité des données, quand d’autres vous parleront de standardisation. Vous avez d’ailleurs vous-même peut-être votre propre interprétation.

La norme ISO 9000-2015 définit la qualité comme “L’aptitude d’un ensemble de caractéristiques intrinsèques à satisfaire des exigences”.

DAMA International (The Global Data Management Community) – association internationale de référence regroupant les professionnels métiers et techniques de la gestion de la donnée – dérive cette définition dans le contexte data : La qualité des données est le degré auquel les dimensions des données répondent aux exigences.

L’approche dimensionnelle de la qualité de la donnée

Opérationnellement, la qualité de la donnée se traduit dans ce que l’on appelle les dimensions de la Data Quality, où chaque dimension se réfère à un aspect spécifique de la qualité. Les quatre dimensions les plus fréquemment utilisées sont généralement la complétude, la précision, la conformité et la disponibilité.

On trouve dans la littérature un grand nombre de dimensions et critères différents qui permettent de décrire la qualité de la donnée. Mais il faut bien comprendre qu’il n’y a pas aujourd’hui de consensus sur ce que sont ces dimensions. DAMA définit par exemple soixante dimensions – quand la plupart des vendeurs de logiciels de Data Quality Management en proposent généralement cinq ou six.

Les neuf dimensions de la qualité des données

Chez Zeenea, nous pensons que le compromis idéal est de prendre en compte neuf dimensions de la qualité des données, à savoir : la complétude, la précision, la conformité, l’unicité, la cohérence, la fraîcheur, la traçabilité, la clarté et la disponibilité.

Nous vous proposons d’illustrer ces neuf dimensions et les différents concepts abordés dans cette publication avec un exemple simple :

Arthur a pour responsabilité d’envoyer des campagnes marketing à ses clients et prospects pour présenter les nouvelles offres de son entreprise. Il rencontre un certain nombre de problèmes :

- Arthur envoie parfois plusieurs fois des communications aux mêmes personnes,

- Les emails renseignés dans son CRM sont souvent invalides,

- Les prospects et clients ne reçoivent pas toujours le bon contenu,

- Certaines informations sur les prospects sont obsolètes,

- Des clients reçoivent des emails avec des erreurs de qualification du

- genre,

- Il y a deux adresses pour les clients et prospects mais il n’est pas évident de comprendre à quoi elles correspondent,

- Il ne sait pas toujours d’où viennent les données qu’il exploite ou comment il peut accéder à leurs sources.

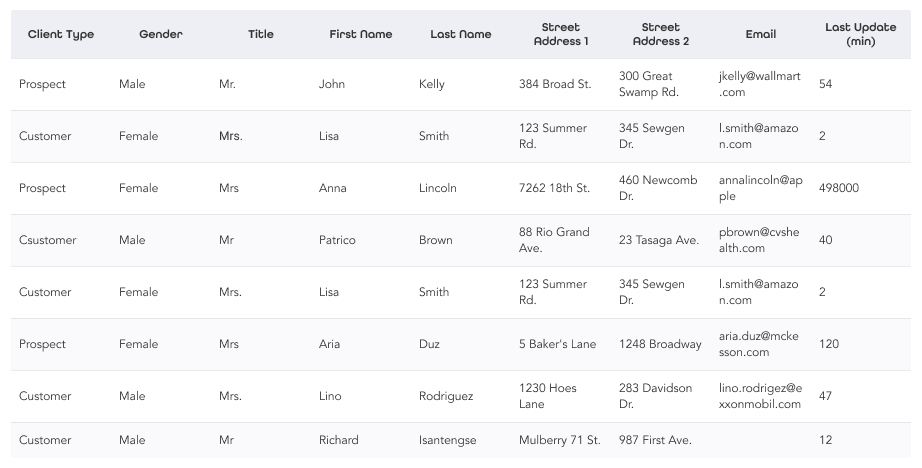

Les données suivantes sont celles à disposition d’Arthur pour sa prospection commerciale. Nous allons les utiliser pour illustrer chacune des neuf dimensions de la Data Quality :

1. La complétude (Completeness)

Est ce que la donnée est complète ? Manque-t-il des informations ? L’objectif de cette dimension est d’identifier les données vides, nulles ou manquantes. Dans notre cas pratique, Arthur a constaté qu’il y a des adresses emails qui ne sont pas renseignées :

Pour pallier ce problème, il pourrait essayer d’identifier si d’autres systèmes contiennent ces informations. Arthur pourrait également demander à des spécialistes de ces données de renseigner manuellement les adresses email manquantes.

2. La précision (Accuracy)

Est-ce que les valeurs présentes sont cohérentes avec les données réelles, c’est-àdire celles que l’on retrouve dans le monde réel ?

Arthur a constaté que des lettres envoyées aux clients importants sont renvoyées car les adresses postales ne sont pas correctes. On constate effectivement que l’une des adresses ne correspond pas au format des adresses du monde réel :

Il pourrait être intéressant pour Arthur d’utiliser des services de vérification des adresses postales.

3. La conformité (Validity)

Est-ce que la donnée est conforme à la syntaxe de sa définition ? L’objectif de cette dimension est de s’assurer que la donnée respecte un modèle ou une règle particulière.

Arthur a constaté qu’il reçoit régulièrement des retours pour emails invalides. Autre problème, il s’avère que certains prospects et clients ne reçoivent pas le bon contenu car ils ne sont pas correctement qualifiés. On constate qu’effectivement l’adresse email annalincoln@apple n’a pas le bon format et que le type de client Csutomer n’est pas correct.

Pour résoudre ce type de problème, il peut par exemple s’assurer que les valeurs Client Type font partie d’une liste de valeurs de référence (Customer ou Prospect) et que l’adresse email respecte un format spécifique.

4. La cohérence (Consistency)

Est ce que différentes valeurs d’un même enregistrement sont en conformité par rapport à une règle ? L’objectif est de s’assurer de la cohérence des données entre plusieurs colonnes.

Arthur a constaté que certains de ses clients masculins se plaignent de recevoir des mails en étant qualifiés à tort de Madame. Il y a effectivement une incohérence entre les colonnes Gender et Title pour Lino Rodrigez.

Pour résoudre ce type de problème, il est possible de créer une règle logique qui s’assurera que si le Genre est Male, alors le Title devra être Mr.

5. La fraîcheur (Timeliness)

Est-ce que la période entre le moment de la création de la donnée et sa disponibilité est appropriée ? L’objectif est de s’assurer que la donnée est accessible dans des délais raisonnables par rapport à son utilisation.

Arthur a constaté que certaines informations sur les prospects ne sont pas à jour car les données sont trop vieilles. Effectivement, dans son métier et pour son entreprise, une donnée liée à un prospect qui a plus de 6 mois ne devrait pas être utilisée.

Il pourrait imaginer pallier ce problème en créant une règle pour identifier et exclure les données trop anciennes. Une autre alternative serait de récupérer la même information dans un autre système qui contiendrait une donnée plus fraîche.

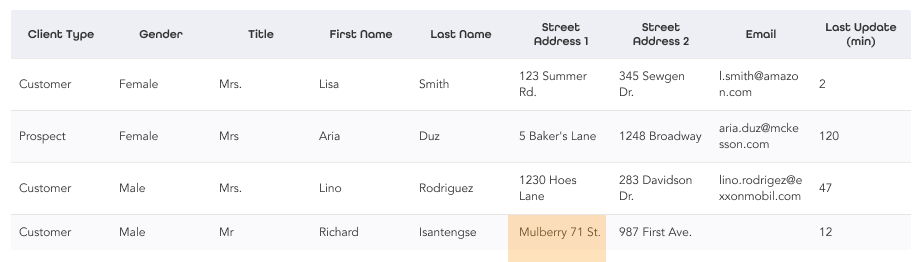

6. L’unicité (Uniqueness)

Y a-t-il des enregistrements présents plus d’une fois ? L’objectif est de s’assurer que les données ne sont pas dupliquées.

Arthur a constaté qu’il a envoyé les mêmes communications plusieurs fois aux mêmes personnes. On observe que le client Lisa Smith est dupliqué dans le fichier :

Dans cet exemple simplifié, les données dupliquées sont exactement les mêmes. Des algorithmes plus avancés de type Jaro, Jaro-Winkler ou Levenshtein – par exemple – permettent de regrouper plus finement les données dupliquées.

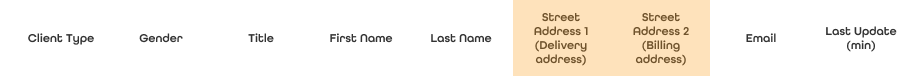

7. La clarté (Clarity)

Est-il simple pour les consommateurs de la donnée d’en comprendre les métadonnées ? L’objectif est de comprendre la signification des données et d’éviter les interprétations.

Arthur a eu des doutes sur les deux adresses présentes car il n’est pas évident de comprendre à quoi elles correspondent. Les noms Street Address 1 et Street Address 2 sont sujets à interprétation et devraient autant que possible être modifiés.

Le renommage au sein d’une base de données est souvent une opération compliquée, et doit être correctement documenté avec au moins une description.

8. La traçabilité (Traceability)

Est-il possible d’obtenir la traçabilité des données ? L’objectif est d’accéder aux origines de la donnée, ainsi qu’aux transformations qu’elle aurait pu subir.

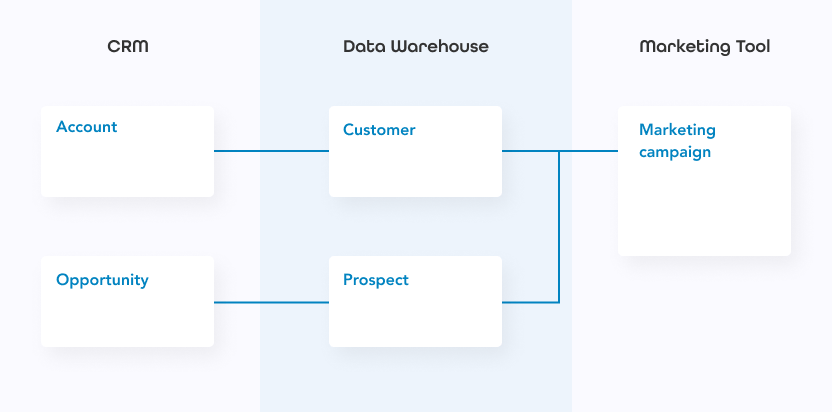

Arthur ne sait pas très bien d’où viennent ses données et comment il peut accéder aux données sources. Cela pourrait pourtant lui être très utile, notamment pour s’assurer que les problèmes soient bien corrigés à la source. Il aurait donc besoin de savoir que les données qu’il utilise avec son outil marketing proviennent des données du data warehouse de son entreprise, provenant elles-même de l’outil de CRM.

9. La disponibilité (Availability)

Comment les données peuvent-elles être consultées ou récupérées par les consommateurs ? L’objectif est de faciliter l’accès aux données.

Arthur ne sait pas comment il pourrait facilement accéder aux données sources. Si on reprend le schéma précédent, il aimerait pouvoir accéder simplement et rapidement aux données du data warehouse et/ou de l’outil CRM. Arthur devra dans certains cas faire une demande avant de pouvoir accéder directement à ces informations.

Découvrez notre guide de la gestion de la qualité des données

Pour plus d’informations sur la qualité des données et la discipline du DQM, téléchargez notre guide gratuit : « Guide du Data Quality Management » dès maintenant !