La qualité de la donnée, Data Quality en anglais, fait référence à la capacité d’une entreprise à maintenir la pérennité de ses données à travers le temps. À écouter certains professionnels de la qualité des données on peut avoir le sentiment qu’améliorer la qualité des données est la solution à tous les problèmes métiers – que cela devrait donc être une top priorité.

Chez Zeenea, la réalité est, selon nous, à nuancer : la Data Quality devrait être considérée uniquement comme un moyen parmi d’autres de réduire l’incertitude d’atteindre les objectifs de votre entreprise.

Dans cette série d’articles, nous vous livrerons tout ce que les professionnels des données doivent savoir sur la gestion de la qualité des données ou Data Quality Management (DQM) :

- Les neuf dimensions de la qualité de la donnée

- Les défis et risques liés à la qualité des données

- Les principales fonctionnalités d’un outil de DQM

- La contribution du Data Catalog au DQM

Les entreprises face au défi de la qualité des données

Les initiatives d’amélioration de la qualité des données sont traditionnellement mises en place par les entreprises pour répondre aux exigences de conformité et de réduction des risques. Elles sont également indispensables pour faciliter la prise de décision fiable.

Il existe malheureusement de nombreuses frictions qui peuvent empêcher d’atteindre ces objectifs d’amélioration de la qualité des données. En voici quelques exemples :

- La croissance exponentielle du volume, de la vitesse et de la variété des données rend l’environnement plus complexe etincertain ;

- La pression croissante des réglementations de conformité telles que RGPD, BCBS 239 ou HIPAA ;

- Les équipes sont de plus en plus décentralisées, avec chacune leur domaine de compétence ;

- Les équipes IT et Data sont débordées et n’ont pas le temps de traiter le sujet de la Data Quality ;

- Ces mêmes équipes peuvent parfois éviter la tâche qu’il trouvent ingrate ;

- Les processus sont complexes et longs pour agréger les données ;

- Il peut être difficile de standardiser les données entre différentes sources ;

- L’audit des changements entre les systèmes est complexe ;

- Les politiques de gouvernance sont difficiles à mettre en oeuvre.

D’un autre côté, les opportunités sont également nombreuses. S’assurer d’avoir des données de qualité permet notamment aux entreprises de faciliter l’innovation avec l’intelligence artificielle, au service de la création d’une expérience personnalisée pour les clients. Mais encore faut-il avoir suffisamment de données de qualité.

Gartner prédit ainsi que jusqu’en 2022, 85 % des projets d’IA produiront des résultats erronés en raison de biais dans les données, les algorithmes ou les équipes chargées de les gérer.

Diminuer le niveau de risque en améliorant la qualité des données

La mauvaise qualité des données devrait être considérée comme un risque, et les logiciels qui améliorent la qualité comme des traitements possibles pour réduire ce niveau de risque.

Le processus de traitement d’un problème de qualité :

Si l’on part du postulat précédent, tout problème de qualité devrait alors être adressé en plusieurs phases :

1. Identification des risques : cette phase consiste à rechercher, reconnaître et décrire les risques qui peuvent aider ou empêcher l’entreprise d’atteindre ses objectifs – et notamment en raison d’un manque de qualité de données.

2. L’analyse du risque : cette phase a pour objectif de comprendre la nature du risque et ses caractéristiques. Elle inclut des facteurs de vraisemblance d’événements et leurs conséquences, la nature et l’importance de ces conséquences, l’efficacité des moyens de maîtrise existants etc.

On va donc chercher ici à identifier ce qui a pu causer la mauvaise qualité des données marketing. On pourrait citer par exemple :

- Une mauvaise expérience utilisateur du système source qui entraîne des erreurs de saisie ;

- Un manque de vérification de la complétude, la précision, la conformité, l’unicité, la cohérence ou la ponctualité des données ;

- Un manque de moyens simples pour assurer la traçabilité, la clarté et la disponibilité des données ;

- L’absence de process de gouvernance et d’implication des équipes métiers.

3. L’évaluation du risque : cette phase vise à comparer les résultats de l’analyse du risque avec les critères de risque établis. Elle permet de déterminer si une action supplémentaire est exigée pour la prise de décision – par exemple maintenir les moyens existants, examiner les options de traitement, ou encore entreprendre une analyse plus approfondie etc.

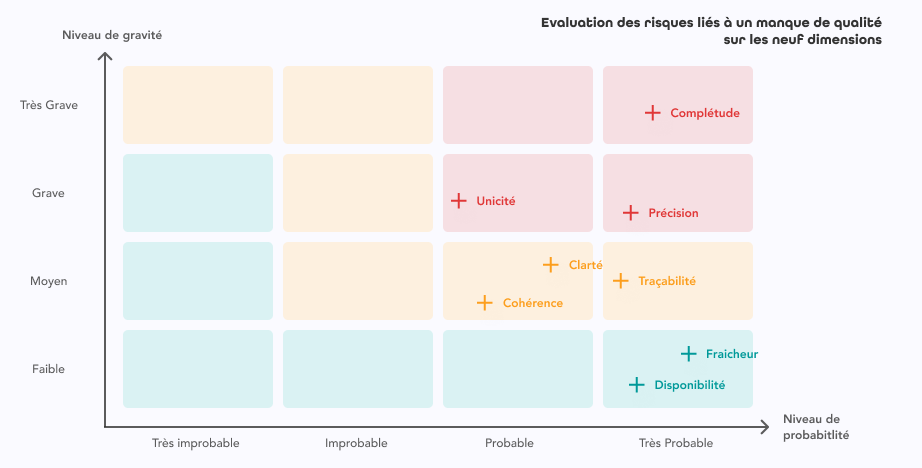

Concentrons-nous sur les neuf dimensions de la Data Quality et essayons d’évaluer l’impact d’une mauvaise qualité sur chacune d’entre elles en nous appuyant sur une matrice probabilité / gravité :

Les valeurs renseignées pour les niveaux de probabilité et de gravité doivent être définies avec les principales parties prenantes, c’est-à-dire les opérationnels qui connaissent le mieux les données en question.

4. Traitement du risque : cette phase de traitement a pour but d’établir les options à choisir pour réduire le risque et mettre en œuvre les actions pour y parvenir. Ce traitement implique aussi d’apprécier l’efficacité des actions menées, de déterminer si le risque résiduel est acceptable ou non – et dans ce dernier cas – d’éventuellement envisager un traitement complémentaire.

L’amélioration de la qualité de la donnée n’est donc pas un but en soi :

- Son coût doit être évalué au regard des objectifs de l’entreprise ;

- Les traitements à mettre en place doivent être évalués à travers chacune des dimensions de la qualité.

Découvrez notre guide de la gestion de la qualité des données

Pour plus d’informations sur la qualité des données et la discipline du DQM, téléchargez notre guide gratuit : « Guide du Data Quality Management » dès maintenant !