Data Catalog & Enterprise Data Marketplace

Zeenea Data Discovery Platform is a cloud-native SaaS solution that democratizes data access

and accelerates all your data-driven business initiatives

Our two modern data discovery solutions

![]()

Data Catalog

Democratize data with a cataloging solution that centralizes and unifies all enterprise metadata into a single source of truth.

![]()

Enterprise Data Marketplace

Enhance your Data Catalog with a one-stop shop to publish, share, and consume the most valuable enterprise data products.

Our platform’s advanced capabilities

Empower your business with a clear & reliable data asset landscape at the enterprise level

Business Glossary

Build and share a common data vocabulary across your entire organization with an automated business glossary.

Data Compliance

Manage personal data assets and ensure that policies and regulations are well communicated to all data consumers.

Data Discovery

Quickly find and understand the relevant data for your business use cases with our enhanced data discovery features.

Data Governance

Drive successful business initiatives with active and agile data governance: trusted, compliant and secure data for your business users.

Data Lineage

Provide your data teams with a complete view of the data lifecycle, from collection to exploitation, storage and preservation over time.

Data Quality

Data Shopping

Zeenea enables data consumers to shop for Data Products and other valuable catalog objects in an Enterprise Data Marketplace.

Data Stewardship

Reduce the time spent on documentation tasks, break data silos and increase your enterprise data knowledge.

Metadata Management

Activate your metadata to power your data & analytics use cases: collect, inventory, and share metadata across all data sources.

Business Glossary

Build and share a common data vocabulary across your entire organization with an automated business glossary.

Data Compliance

Manage personal data assets and ensure that policies and regulations are well communicated to all data consumers.

Data Discovery

Quickly find and understand the relevant data for your business use cases with our enhanced data discovery features.

Data Governance

Drive successful business initiatives with active and agile data governance: trusted, compliant and secure data for your business users.

Data Lineage

Provide your data teams with a complete view of the data lifecycle, from collection to exploitation, storage and preservation over time.

Data Quality

Connect Zeenea to your Data Quality Management DQM solution to synchronize and display datasets’ quality metrics to your data users right from the discovery phase.

Data Shopping

Zeenea enables data consumers to shop for Data Products and other valuable catalog objects in an Enterprise Data Marketplace.

Data Stewardship

Reduce the time spent on documentation tasks, break data silos and increase your enterprise data knowledge.

Metadata Management

Activate your metadata to power your data & analytics use cases: collect, inventory, and share metadata across all data sources.

Solutions that your teams will love

Data Managers

Maintain, control, and manage your data and data products to ensure secure and quality information for data-driven decision-making.

Data Producers

Curate, document, and monitor your data and data products to maximize data discovery for your data & analytics teams.

Data Consumers

Get rich and in-depth search results and get personalized exploratory paths for increased data and data products discovery.

Data leaders recommend Zeenea

Your tooltip content goes here

Your tooltip content goes here

Your tooltip content goes here

A platform powered by next-gen technologies

Easy to set up use scale

Cloud & SaaS

Our data discovery platform is cloud-native and developed as-a-Service (SaaS) to help enterprises reduce risks, optimize costs, and simplify data access across the organization.

Knowledge Graph

Our powerful knowledge graph combines flexibility and intuitive user experiences to deliver enhanced data discovery and governance.

Universal connectivity

Our data discovery platform enables companies to automatically scan, collect, and update the data from your various data sources.

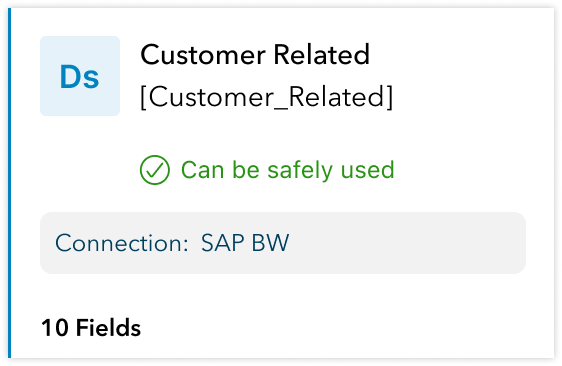

Zeenea connects to all your data sources in seconds

Listen to The Data Democracy Podcast

Presented by Ole Olesen-Bagneux, author of ‘The Enterprise Data Catalog’ (O’Reilly)

Bettina BERG

Bettina BERG

Naima BADIDI

Naima BADIDI Daniela ZELMER

Daniela ZELMER

Ruben Marco GANZAROLI

Ruben Marco GANZAROLI