Le rôle des data catalogs dans l’accélération des initiatives d’IA

Les organisations s’appuient de plus en plus sur l’IA pour dégager des tendances, stimuler l’innovation et maintenir un avantage concurrentiel. En effet, les technologies de l’IA, y compris le machine learning, le traitement du langage naturel et l’analyse prédictive, transforment les opérations des entreprises, leur permettant de prendre des décisions plus intelligentes, d’automatiser les processus et de découvrir de nouvelles opportunités. Cependant, le succès des initiatives d’IA dépend de manière significative de la qualité, de l’accessibilité et de la gestion efficace des données.

C’est ici que la mise en place d’un data catalog joue un rôle crucial.

En facilitant la gouvernance des données, leur découverte et leur accessibilité, les catalogues de données permettent aux organisations de tirer pleinement parti de leurs projets d’IA, en s’assurant que les modèles d’IA sont construits sur une base solide de données précises et bien organisées.

Tout d’abord : qu’est-ce qu’un data catalog ?

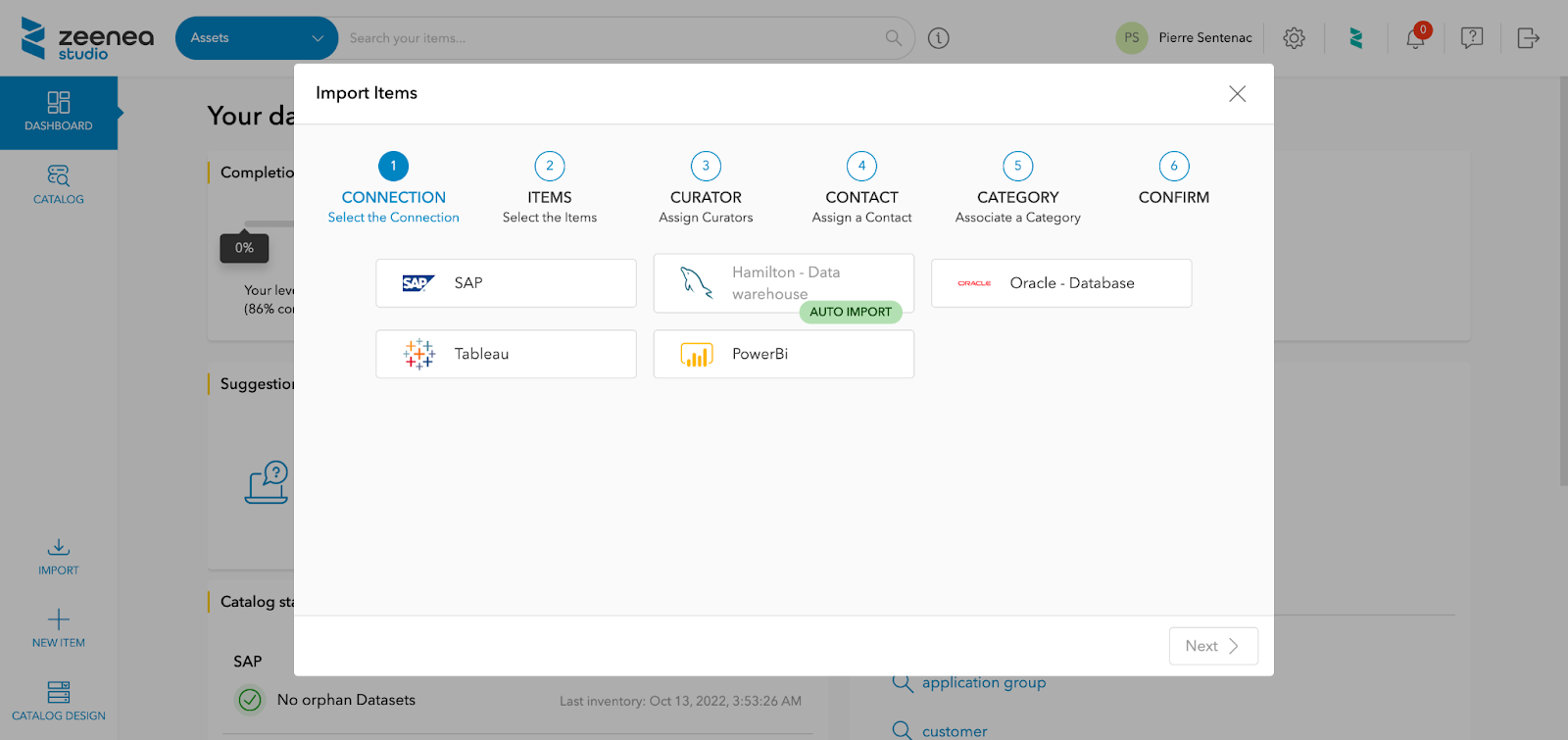

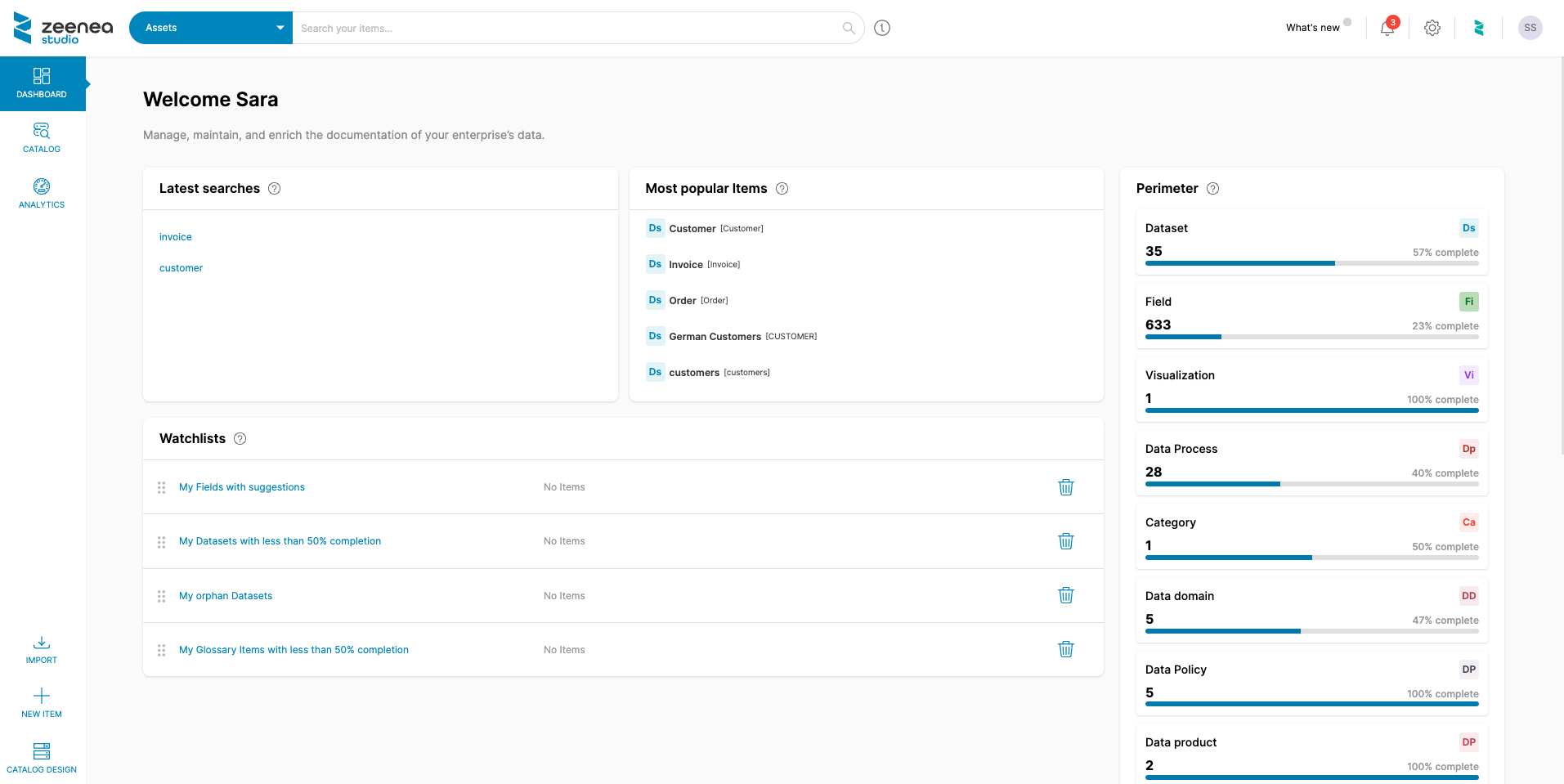

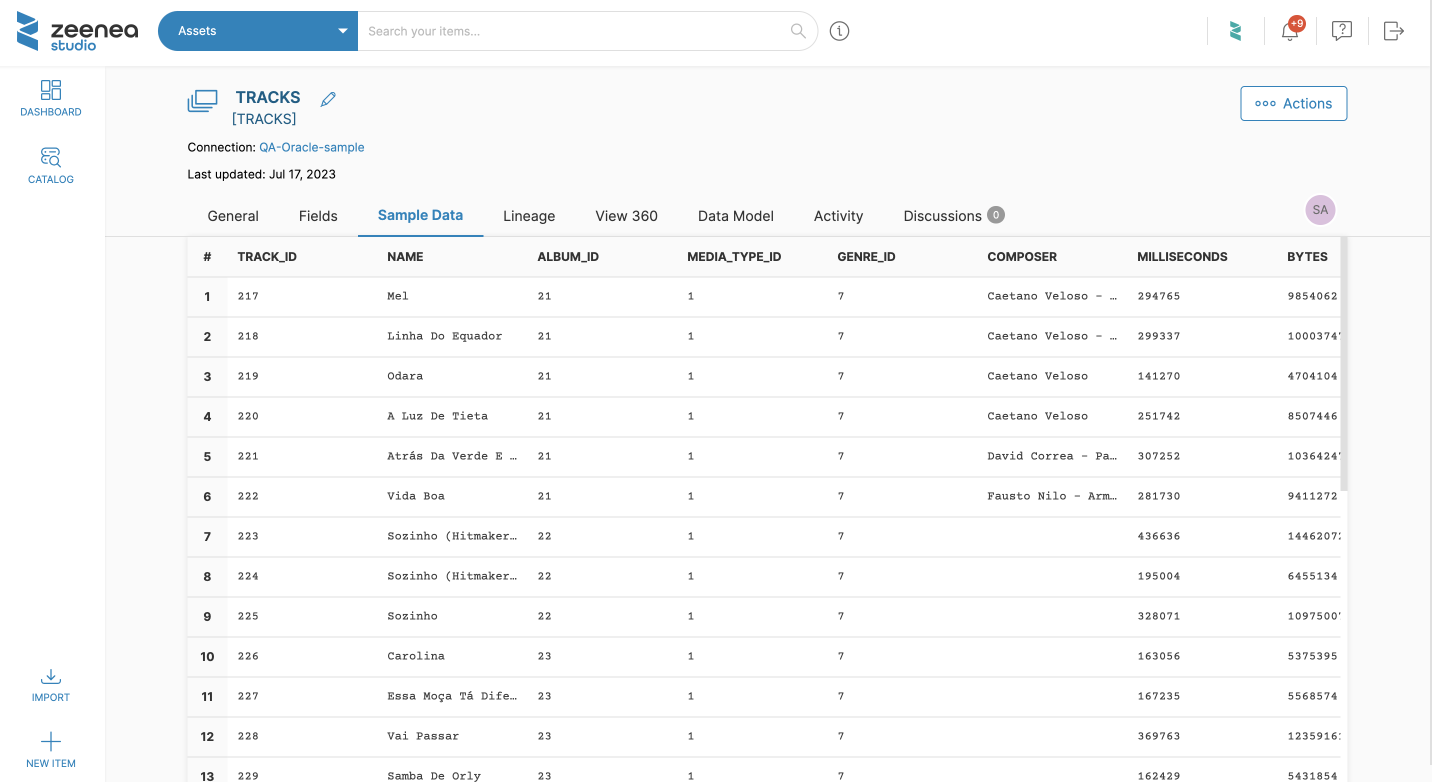

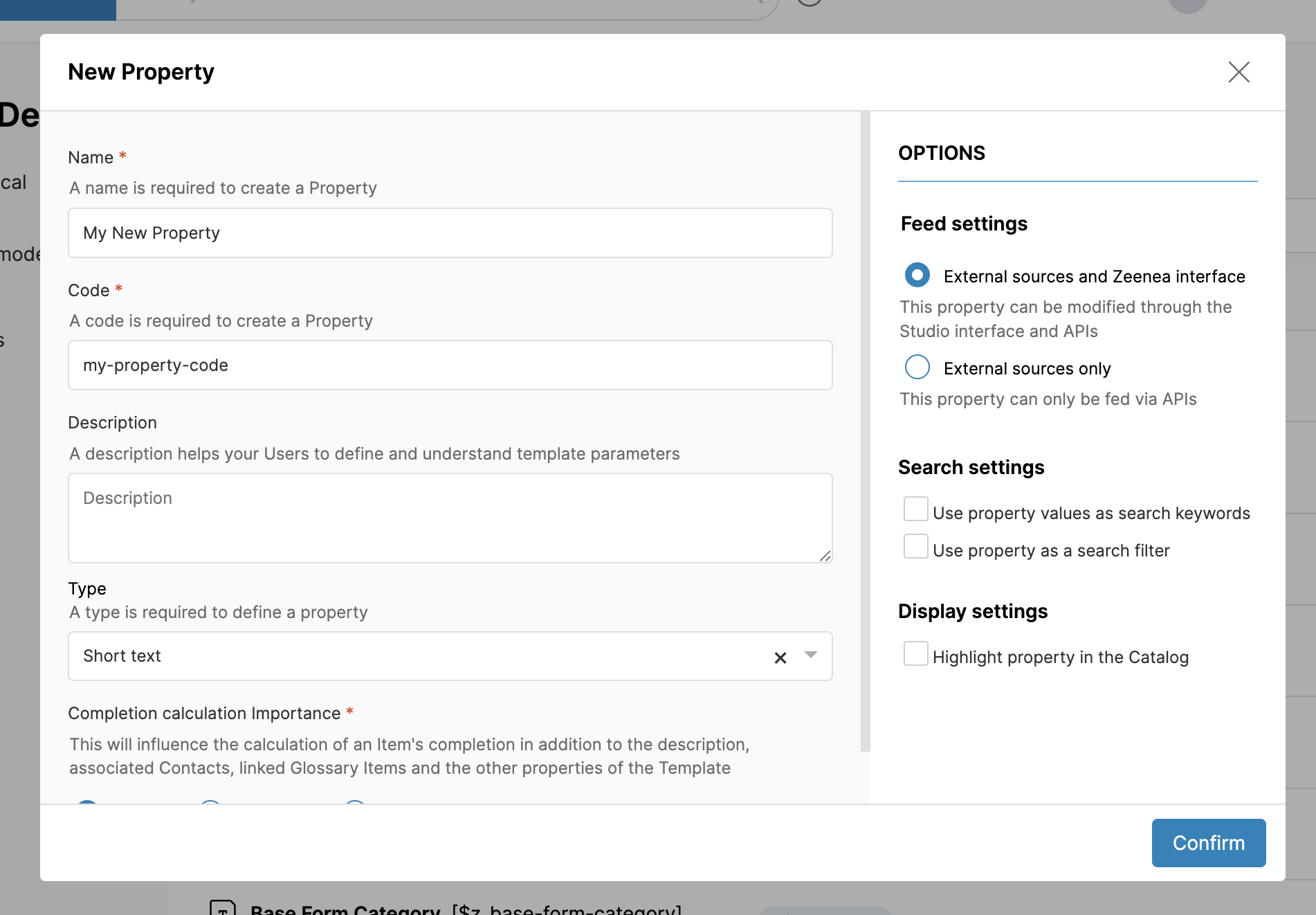

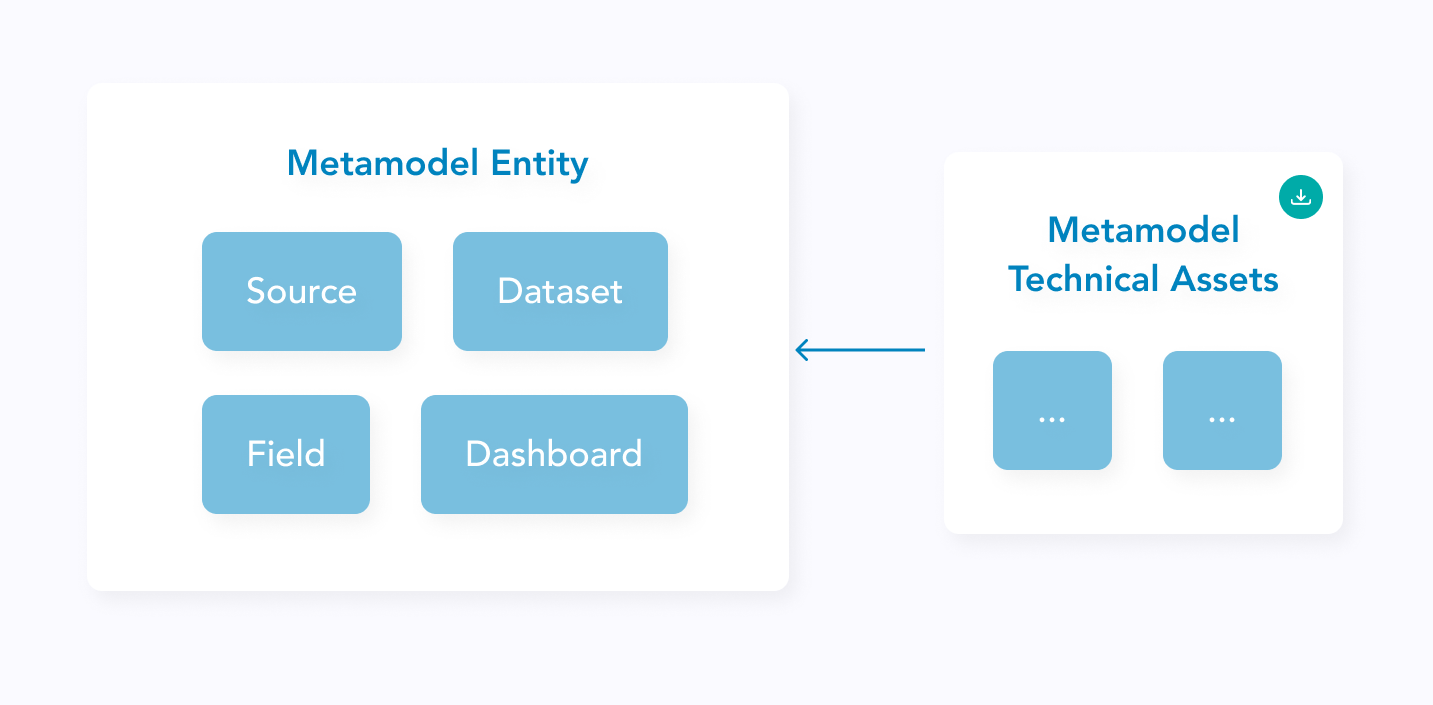

Un data catalog est un référentiel centralisé qui stocke les metadonnées—des données sur les données—permettant aux organisations de gérer plus efficacement leurs actifs data. Ces metadata collectées par diverses sources de données sont automatiquement scannées pour permettre aux utilisateurs du catalogue de rechercher leurs données et d’obtenir des informations telles que leur disponibilité, leur fraîcheur et leur qualité.

Par conséquent, un data catalog est devenu un outil essentiel pour une gestion des métadonnées efficace et la découverte des données. Chez Zeenea, nous définissons un data catalog comme étant :

Un inventaire détaillé de tous les actifs informationnels disponibles dans une organisation ainsi que des métadonnées permettant d’exploiter ces actifs.

Comment le data catalog accélère-t-il les initiatives d’IA dans les organisations ?

Maintenant que nous avons brièvement défini ce qu’est un data catalog, découvrons comment ces derniers peuvent stimuler de manière significative les initiatives d’IA dans les organisations :

Découverte de données améliorée

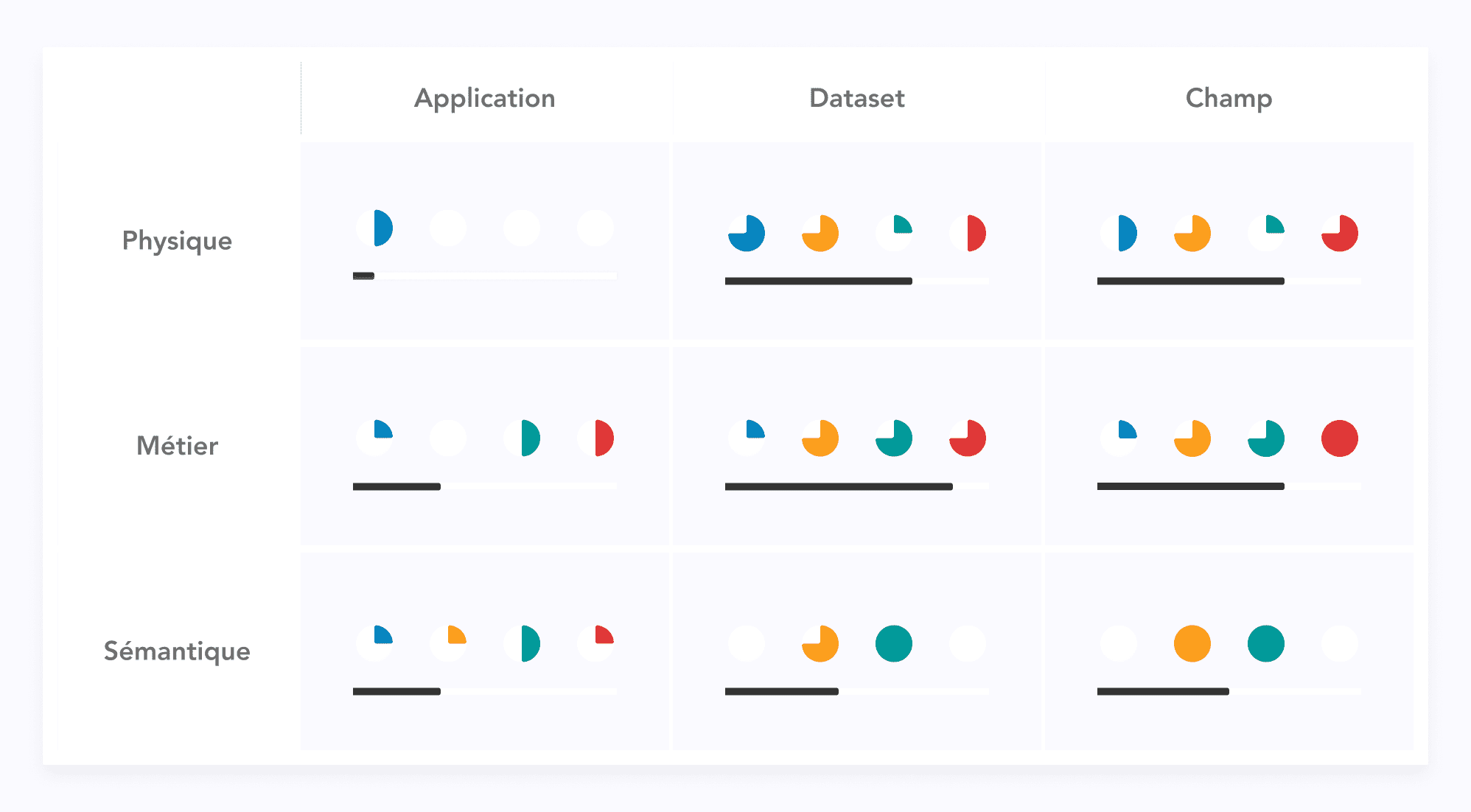

Le succès des modèles d’IA est déterminé par la capacité d’accéder à et d’utiliser de grands ensembles de données diversifiés qui représentent avec précision le champ d’un problème. Un data catalog permet ce succès en offrant des capacités de recherche et de filtrage robustes, permettant aux utilisateurs de trouver rapidement des jeux de données pertinents en fonction de critères tels que des mots-clés, des tags, des sources de données et toute autre information sémantique fournie. Ces fonctionnalités de recherche similaires à Google permettent aux utilisateurs de données de naviguer efficacement dans le patrimoine data de l’organisation et de trouver les actifs dont ils ont besoin pour leurs cas d’usage spécifiques.

Par exemple, un data scientist travaillant sur un modèle de maintenance prédictive pour des équipements de fabrication peut utiliser un data catalog pour localiser des historiques de maintenance, des données de capteurs et des logs opérationnels. Cette découverte de données améliorée est cruciale pour les projets d’IA, car elle permet aux data scientists d’identifier et de récupérer les jeux de données les plus appropriés pour l’entraînement et la validation de leurs modèles.

💡La différence Zeenea : Obtenez des expériences de découverte de données personnalisées avec Zeenea ! Notre plateforme permet aux consommateurs de données de profiter d’une expérience de découverte unique via des parcours exploratoires personnalisés en veillant à ce que chaque profil utilisateur soit pris en compte dans le classement des résultats de recherche. Nos algorithmes fournissent également des recommandations et des suggestions intelligentes sur vos actifs data, jour après jour.

Découvrez nos fonctionnalités de découverte de données.

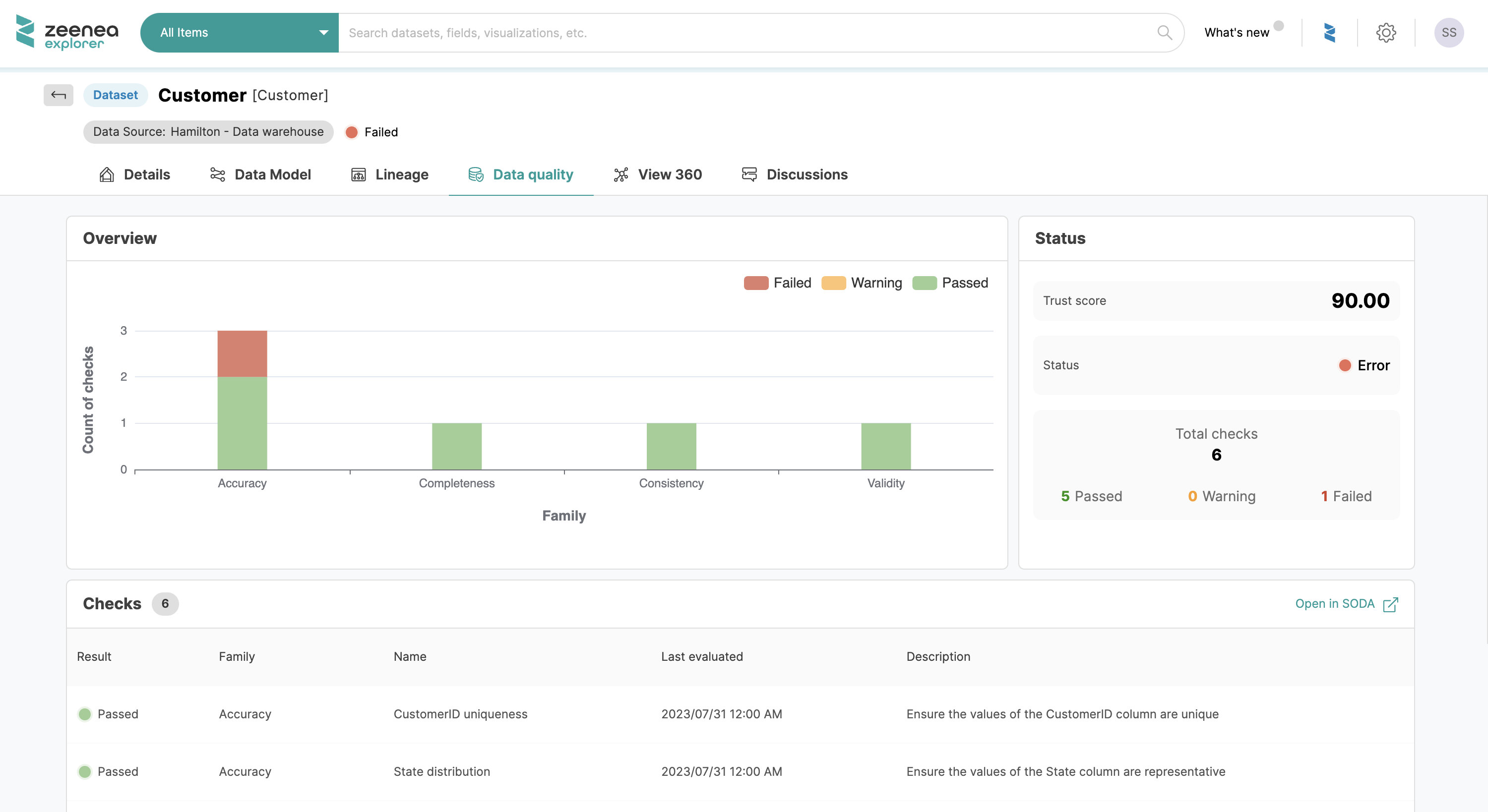

Amélioration de la qualité et de la fiabilité des données

Les données sous-jacentes doivent être de haute qualité pour que les modèles d’IA fournissent des résultats précis et fiables. Des données de haute qualité sont cruciales car elles impactent directement la capacité du modèle à apprendre et à faire des prédictions reflétant des scénarios réels. Des données de mauvaise qualité peuvent entraîner des conclusions incorrectes et des résultats peu fiables, affectant négativement les décisions business.

Un data catalog inclut généralement des fonctionnalités pour le profilage des données et l’évaluation de la qualité. Ces fonctionnalités aident à identifier les problèmes de qualité des données tels que les valeurs manquantes, les incohérences et les valeurs aberrantes, qui peuvent fausser les résultats des modèles d’IA. En s’assurant que seules des données propres et fiables sont utilisées dans les initiatives d’IA, les organisations peuvent améliorer la fiabilité et la performance de leurs modèles.

💡La différence Zeenea : Zeenea s’appuie sur la technologie GraphQL et sur son knowledge graph afin d’offrir une approche flexible pour l’intégration des meilleures solutions de gestion de la qualité des données du marché, directement dans le catalogue. Synchronisez simplement les indicateurs de data quality de vos outils tiers via des requêtes API simples. Les capacités de notre API Catalogue permettent la mise à jour automatique de toutes les modifications apportées dans votre outil de DQM directement au sein de notre plateforme.

Découvrez nos fonctionnalités de qualité des données.

Amélioration de la gouvernance et de la conformité des données

La gouvernance des données est essentielle pour maintenir l’intégrité, la sécurité et la conformité des données avec les exigences réglementaires. Elle implique les processus, politiques et standards qui garantissent que les données sont gérées et utilisées correctement tout au long de leur cycle de vie. Des exigences réglementaires telles que le GDPR en Europe et le CCPA en Californie, États-Unis, sont des exemples de lois strictes auxquelles les organisations doivent se conformer.

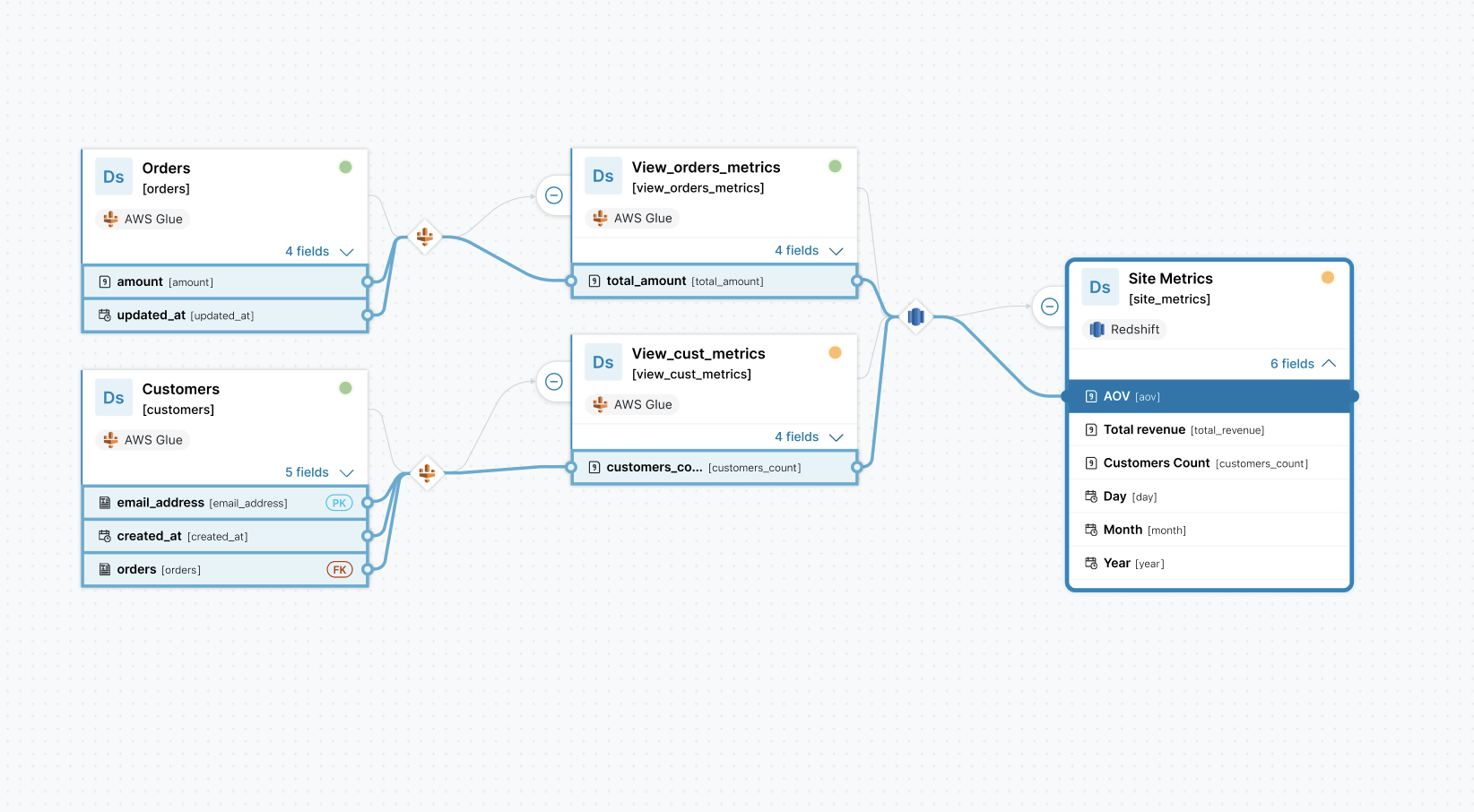

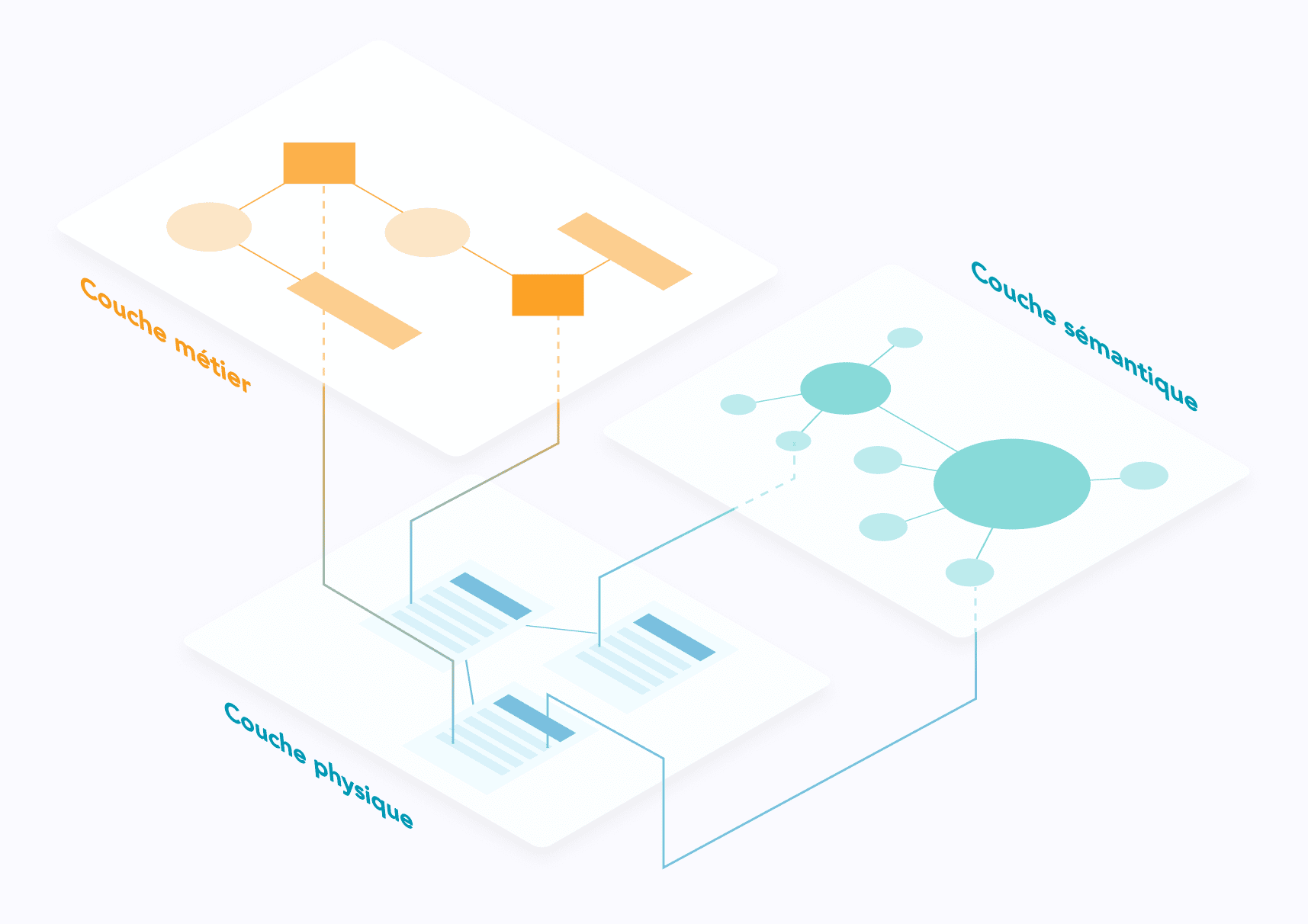

En outre, la gouvernance des données promeut la transparence, la responsabilité et la traçabilité des données, facilitant pour les parties prenantes l’identification des erreurs et la réduction des risques associés à des insights d’IA erronés ou mal représentés avant qu’ils n’affectent négativement les opérations ou n’endommagent la réputation de l’organisation. Les catalogues de données soutiennent ces initiatives de gouvernance en fournissant des metadata détaillées, y compris le data lineage, l’ownership et les politiques d’utilisation.

Pour les initiatives d’IA, une gouvernance des données robuste signifie que les données peuvent être utilisées de manière responsable et éthique, minimisant les risques de violations et de non-conformité. Cela protège l’organisation légalement et éthiquement et renforce la confiance des clients et parties prenantes, garantissant que les initiatives d’IA sont durables et crédibles.

💡La différence Zeenea : Zeenea garantit la conformité réglementaire en identifiant, classifiant et en gérant automatiquement les actifs de données personnelles à l’échelle de l’entreprise. Grâce à des recommandations intelligentes, la plateforme détecte les informations à caractère personnel et donne des suggestions sur les actifs à étiqueter – en veillant à ce que les informations sur les politiques et les réglementations soient bien communiquées à tous les consommateurs de données au sein de l’organisation.

Découvrez nos fonctionnalités de gouvernance des données.

Collaboration et partage des connaissances

Les projets d’IA impliquent souvent des équipes cross-fonctionnelles, y compris des data scientists, des ingénieurs, des analystes et les fonctions business. Les catalogues de données jouent un rôle clé en promouvant la collaboration en servant de plateforme partagée où les membres de l’équipe peuvent documenter, partager et discuter des actifs de données. Des fonctionnalités telles que les annotations, les commentaires et les évaluations des données permettent aux utilisateurs de contribuer directement à leurs insights et connaissances au sein du data catalog. Cette fonctionnalité favorise un environnement collaboratif où les parties prenantes peuvent échanger des idées et itérer sur des tâches liées aux données.

Par exemple, les data scientists peuvent annoter des jeux de données avec des informations sur la qualité ou des caractéristiques spécifiques utiles pour les modèles de machine learning. Les ingénieurs peuvent laisser des commentaires concernant les exigences d’intégration des données ou les considérations techniques. Les analystes peuvent évaluer la pertinence ou l’utilité de différents ensembles de données en fonction de leurs besoins analytiques.

💡La différence Zeenea : Zeenea fournit des onglets de discussion pour chaque objet du catalogue, facilitant une communication efficace entre les Data Stewards et les consommateurs de données concernant leurs actifs. Bientôt, les consommateurs de données pourront également fournir des suggestions concernant le contenu de leurs objets, garantissant une amélioration continue et le maintien de la plus haute qualité de documentation des données au sein du catalogue.

Compréhension commune des termes IA à l’échelle de l’entreprise

Les catalogues de données intègrent souvent un business glossary, ou glossaire métier, un référentiel centralisé pour définir et standardiser les termes business et les définitions des données et de l’IA à travers une organisation. Un business glossary améliore l’alignement entre les parties prenantes business et les gestionnaires des données en établissant des définitions claires et en garantissant la cohérence de la terminologie.

Cette clarté est essentielle dans les initiatives d’IA, où une compréhension et une interprétation précises des données sont cruciales pour développer des modèles précis. Par exemple, un glossaire métier bien défini permet aux data scientists d’identifier rapidement et d’utiliser les bons jeux de données pour entraîner les modèles d’IA, réduisant le temps consacré à la préparation des data et augmentant la productivité. En facilitant une compréhension commune des données à travers les départements, un business glossary accélère les cycles de développement de l’IA et permet aux organisations de tirer des insights significatifs de leur patrimoine data.

💡La différence Zeenea : Zeenea fournit aux équipes de data management un support unique pour créer leurs catégories de concepts sémantiques, les organiser en hiérarchies et configurer la manière dont les objets du glossaire sont associés avec les actifs techniques.

Découvrez nos fonctionnalités de Business Glossary.

En conclusion

Dans un paysage data en constante évolution et l’émergence de prises de décisions basées sur l’IA, les catalogues de données sont devenus des outils indispensables pour les organisations cherchant à exploiter efficacement leurs actifs data. Les data catalogs garantissent que les initiatives d’IA sont bâties sur des données de haute qualité, bien gouvernées et bien documentée. Un socle essentiel pour obtenir des tendances précises et créer de la valeur durablement pour le business.

Alors que les organisations continuent d’investir massivement dans les capacités liées à l’IA, l’adoption d’un data catalog robuste jouera un rôle clé pour maximiser la valeur des actifs de données, stimuler l’innovation et maintenir un avantage concurrentiel.

![[SÉRIE] Data Shopping Partie 2 – L’expérience de Data Shopping dans Zeenea](https://zeenea.com/wp-content/uploads/2024/06/zeenea-data-shopping-experience-blog-image-1080x675.png)

![[SÉRIE] Data Shopping Partie 1 – La consommation de Data Products](https://zeenea.com/wp-content/uploads/2024/06/iStock-1497601141-1080x675.jpg)

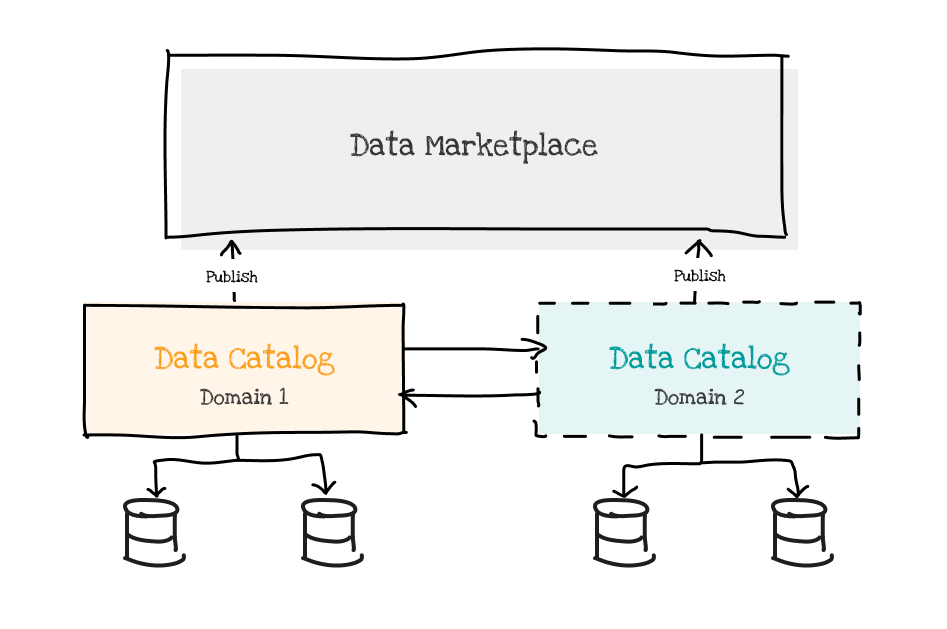

![[SÉRIE] La data marketplace pour le data mesh – Partie 3 : Alimenter la marketplace via des data catalogs par domaine](https://zeenea.com/wp-content/uploads/2024/06/iStock-1418478531-1080x675.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 2 : Construire une marketplace à l’échelle de l’entreprise](https://zeenea.com/wp-content/uploads/2024/06/iStock-1513818710-1080x675.jpg)

![[SÉRIE] La data marketplace pour le data mesh – Partie 1 : Faciliter la consommation des data products avec les métadonnées](https://zeenea.com/wp-content/uploads/2024/05/iStock-1485944683-1080x675.jpg)