Die Rolle von Datenkatalogen bei der Beschleunigung von KI-Initiativen

Die Unternehmen verlassen sich zunehmend auf KI, um Trends zu erkennen, Innovationen voranzutreiben und ihren Wettbewerbsvorteil zu wahren. Tatsächlich verändern KI-Technologien, einschließlich Machine Learning, Natural Language Processing und Predictive Analytics die Abläufe in Unternehmen und ermöglichen es ihnen, intelligentere Entscheidungen zu treffen, Prozesse zu automatisieren und neue Chancen zu erkennen. Der Erfolg von KI-Initiativen hängt jedoch maßgeblich von der Qualität, der Zugänglichkeit und dem effektiven Management von Daten ab.

Hier spielt die Einrichtung eines Datenkatalogs eine entscheidende Rolle.

Durch die Erleichterung von Data Governance, Data Discovery und Data Accessibility versetzen Datenkataloge Unternehmen in die Lage, das Potenzial ihrer KI-Projekte optimal auszuschöpfen und stellen sicher, dass KI-Modelle auf einer soliden Grundlage präziser und gut organisierter Daten aufgebaut werden.

Zunächst einmal: Was ist ein Datenkatalog?

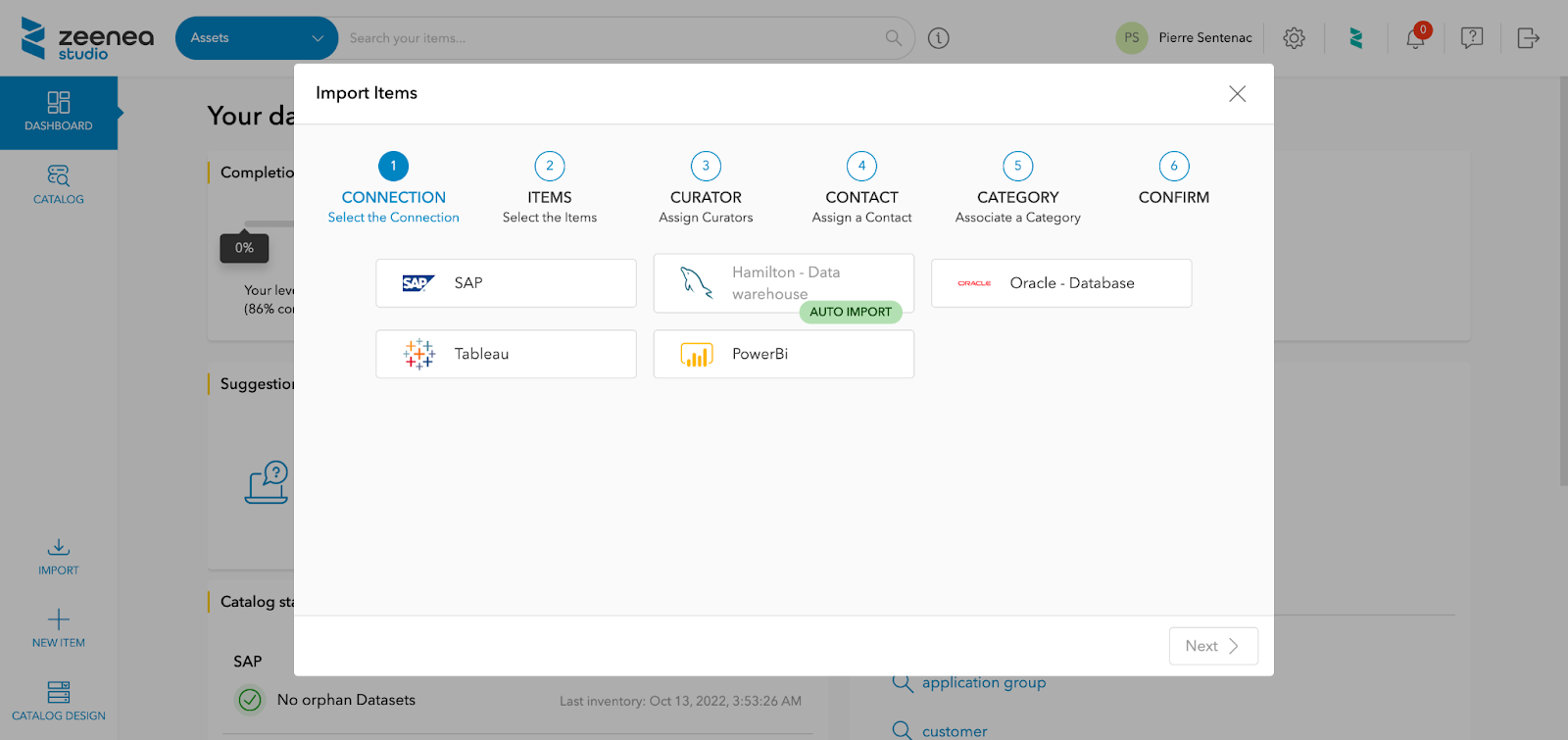

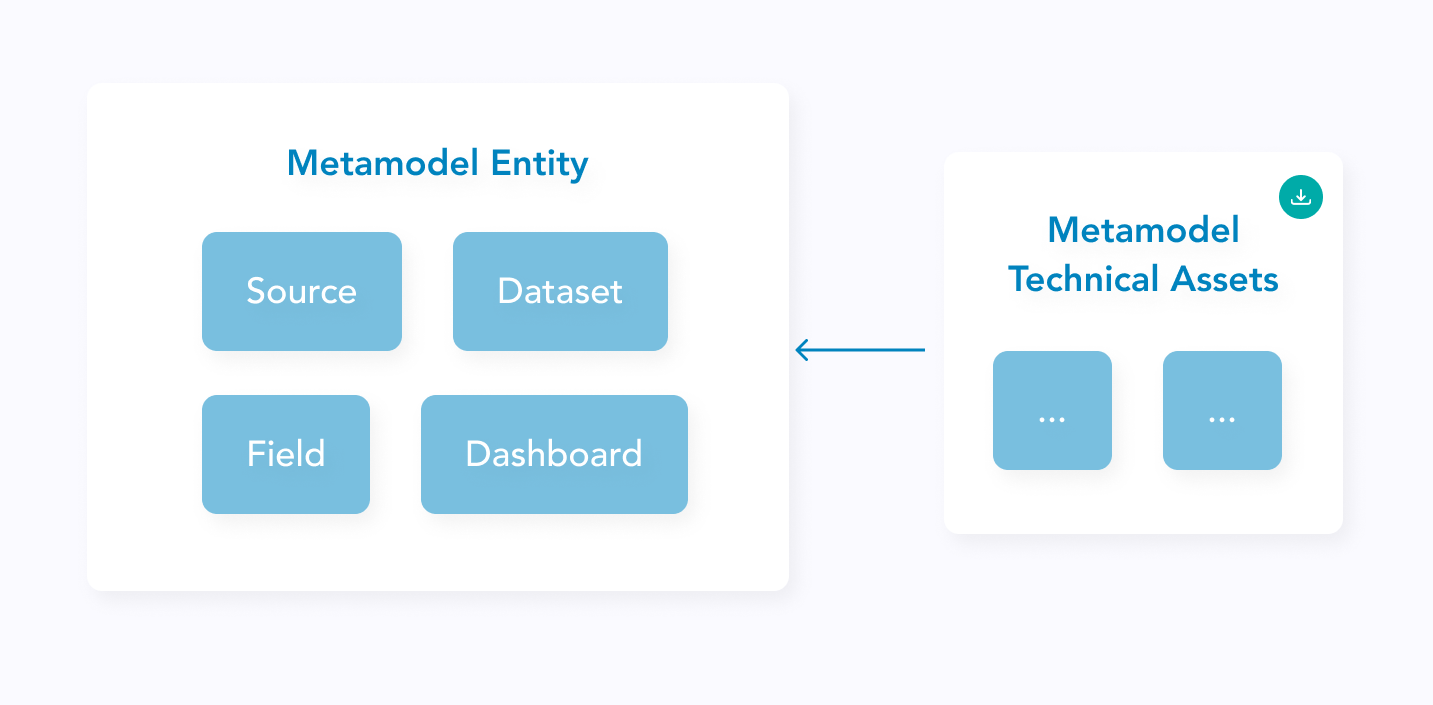

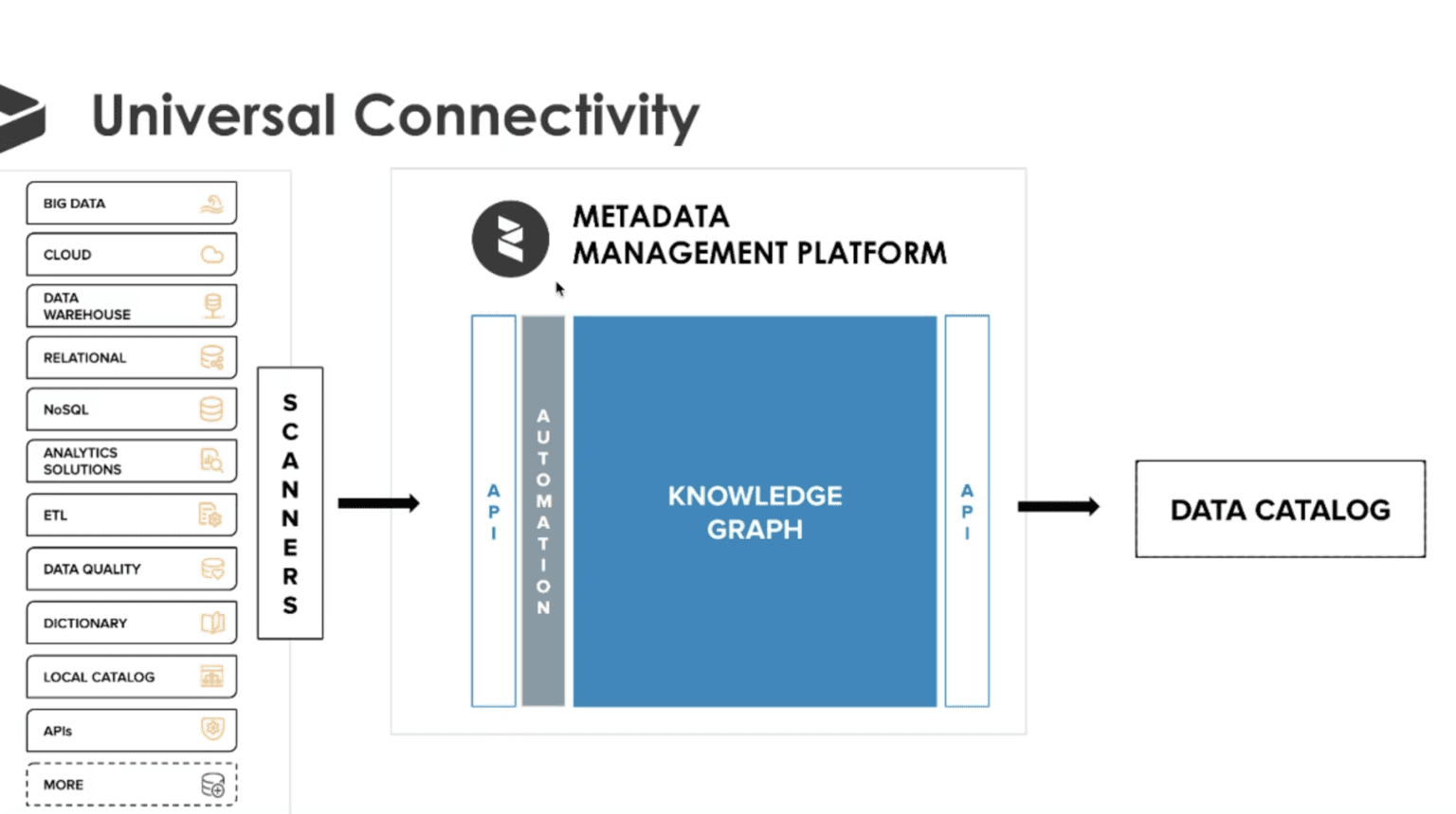

Ein Data Catalog ist ein zentrales Repository, in dem Metadaten – Daten über Daten – gespeichert werden, mit deren Hilfe Organisationen ihre Datenbestände effizienter verwalten können. Diese aus verschiedenen Datenquellen gesammelten Metadaten werden automatisch gescannt, damit die Katalogbenutzer nach ihren Daten suchen können und Informationen wie Verfügbarkeit, Aktualität und Qualität erhalten.

Infolge dessen ist der Datenkatalog zu einem wichtigen Werkzeug für eine effektive Metadatenverwaltung und Data Discovery geworden. Bei Zeenea definieren wir einen Data Catalog wie folgt:

Ein Data Catalog ist ein detailliertes Verzeichnis aller in einer Organisation verfügbaren Daten-Assets sowie der Metadaten, mit deren Hilfe diese Assets genutzt werden können.

Wie beschleunigt ein Datenkatalog die KI-Initiativen in Unternehmen?

Nachdem wir kurz definiert haben, was ein Datenkatalog ist, wollen wir nun herausfinden, wie er die KI-Initiativen in Unternehmen erheblich vorantreiben kann:

Verbesserte Data Discovery

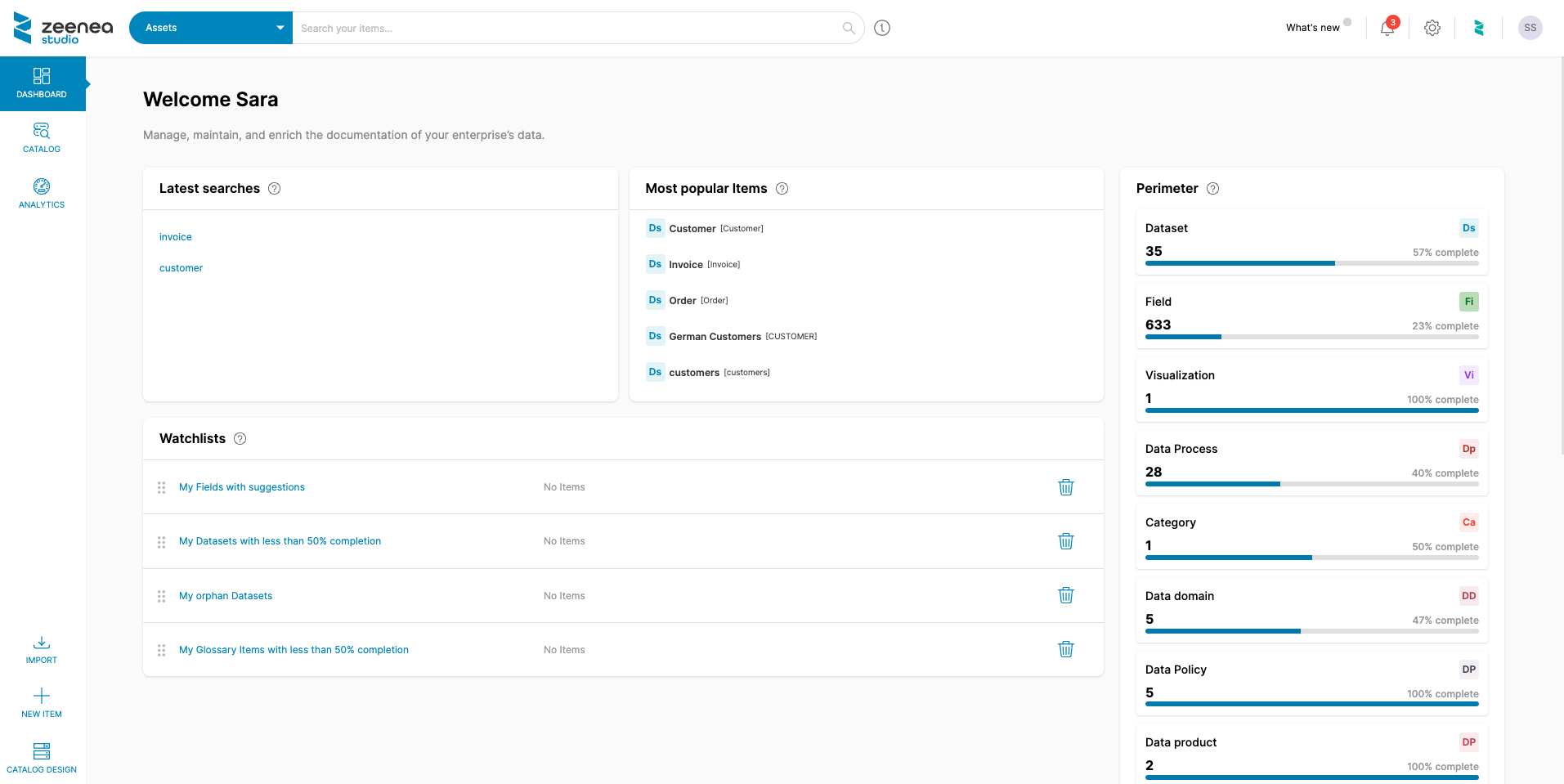

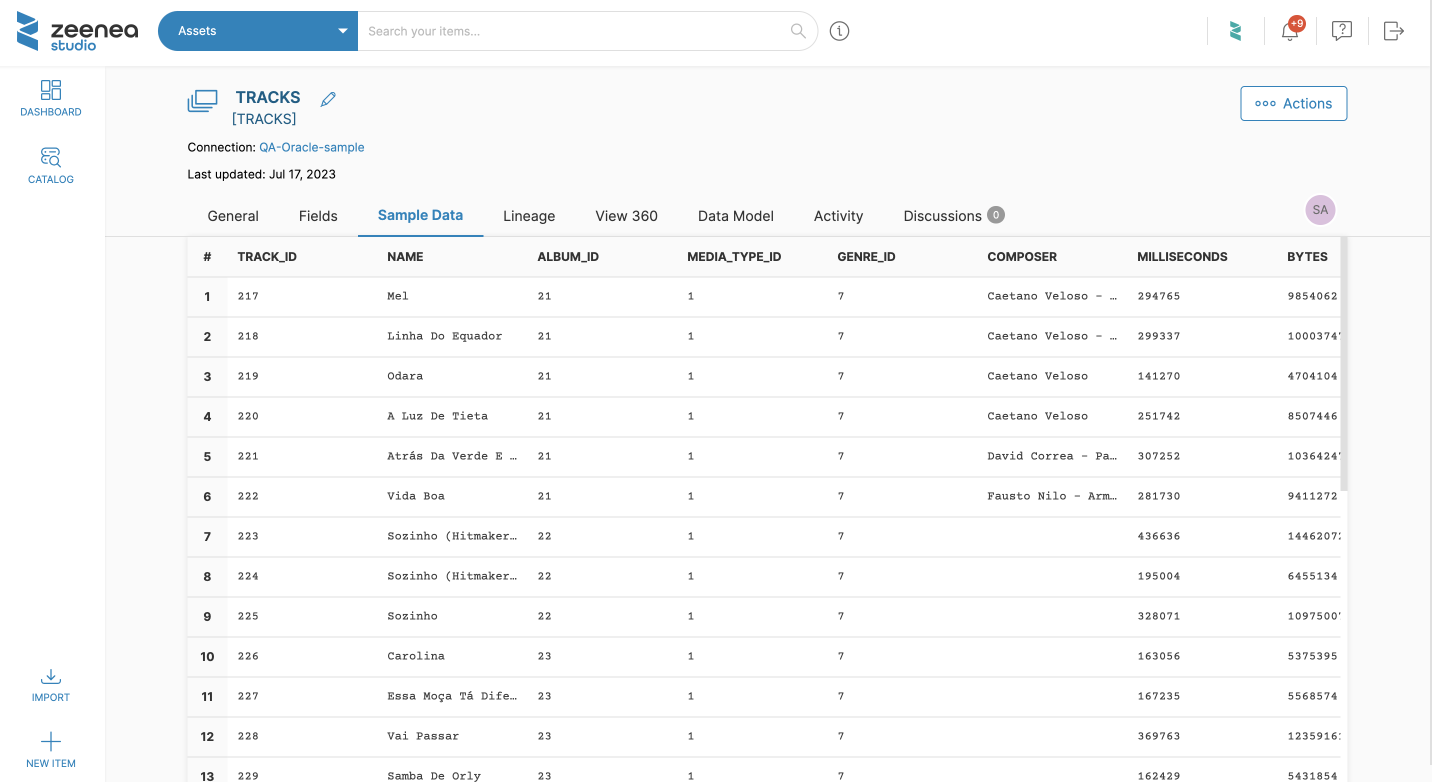

Der Erfolg von KI-Modellen wird durch die Fähigkeit bestimmt, auf große und vielfältige Datensätze, die den Umfang eines Problems genau abbilden, zuzugreifen und diese zu nutzen. Ein Datenkatalog ermöglicht diesen Erfolg, indem er robuste Such- und Filterfunktionen bietet, die es den Benutzern ermöglichen, relevante Datensätze anhand von Kriterien wie Schlagwörtern, Tags, Datenquellen und anderen bereitgestellten semantischen Informationen schnell zu finden. Diese Google-ähnlichen Suchfunktionen ermöglichen es Datennutzern, den Datenbestand der Organisation effizient zu durchsuchen und die Assets zu finden, die sie für ihre spezifischen Anwendungsfälle benötigen.

Beispielsweise kann ein Data Scientist, der an einem Modell für die vorausschauende Wartung von Fertigungsanlagen arbeitet, einen Data Catalog verwenden, um Wartungsverlauf, Sensordaten und Betriebsprotokolle zu lokalisieren. Diese verbesserte Data Discovery ist für KI-Projekte von entscheidender Bedeutung, da Data Scientists mit ihrer Hilfe die Möglichkeit haben, die am besten geeigneten Datensätze für das Training und die Validierung ihrer Modelle zu identifizieren und abzurufen.

💡Was Zeenea unterscheidet: Erhalten Sie mit Zeenea personalisierte Data-Discovery-Erlebnisse! Unsere Plattform ermöglicht Datenkonsumenten ein einzigartiges Nutzererlebnis über personalisierte Discovery-Pfade. Sie stellt sicher, dass jedes Nutzerprofil in der Rangfolge der Suchergebnisse berücksichtigt wird. Unsere Algorithmen liefern außerdem Tag für Tag intelligente Empfehlungen und Vorschläge zu Ihren Datenbeständen.

Entdecken Sie unsere Data-Discovery-Funktionen.

Verbesserung der Qualität und Zuverlässigkeit von Daten

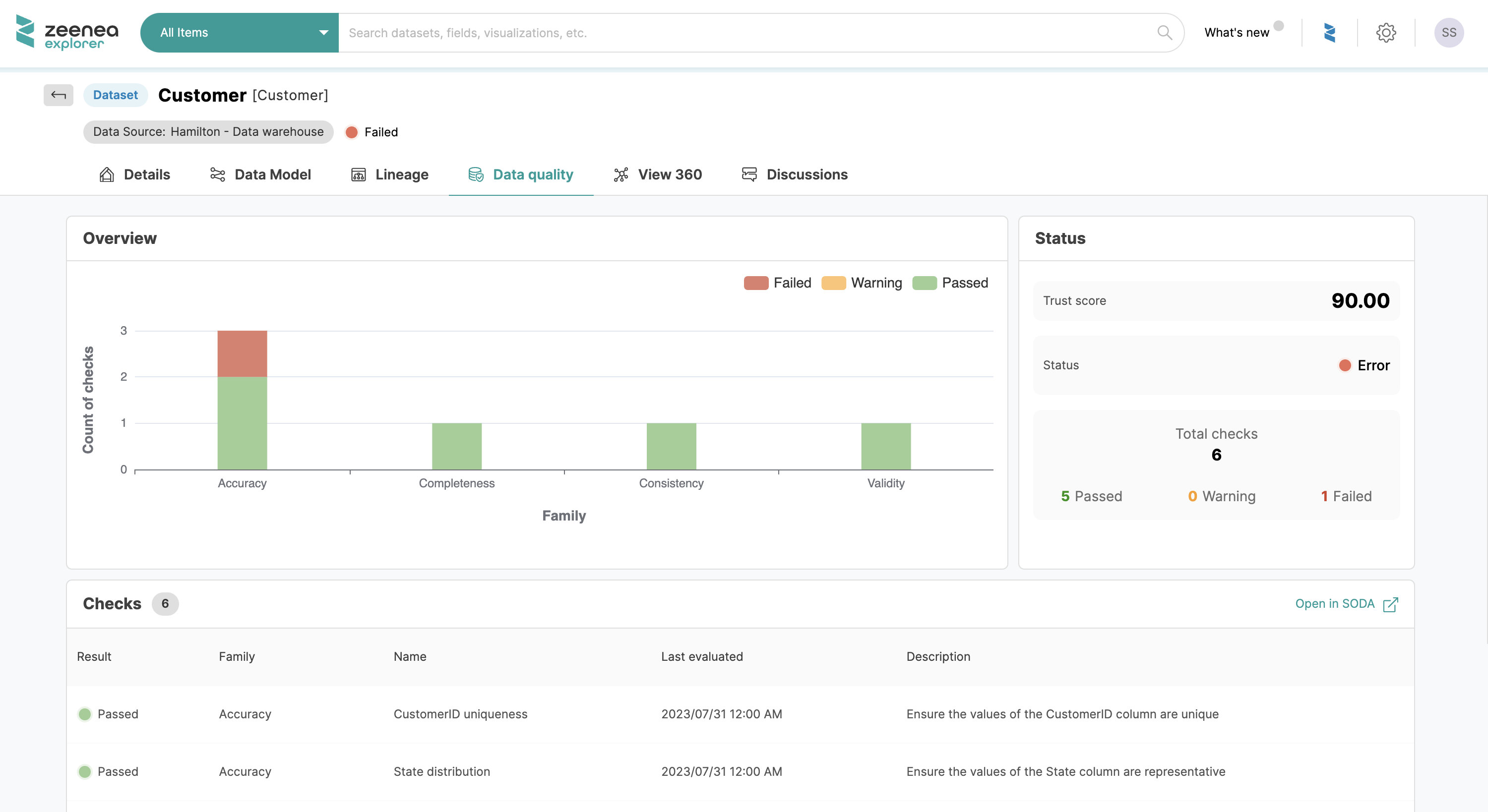

Die zugrunde liegenden Daten müssen von hoher Qualität sein, damit KI-Modelle genaue und zuverlässige Ergebnisse liefern. Qualitativ hochwertige Daten sind entscheidend, da sie sich direkt auf die Fähigkeit des Modells auswirken, zu lernen und Vorhersagen zu treffen, die reale Szenarien widerspiegeln. Daten von schlechter Qualität können zu falschen Schlussfolgerungen und unzuverlässigen Ergebnissen führen, die sich negativ auf geschäftliche Entscheidungen auswirken.

Ein Datenkatalog umfasst in der Regel Funktionen für das Data Profiling und die Qualitätsbewertung. Diese Funktionen helfen bei der Identifizierung von Datenqualitätsproblemen wie fehlenden Werten, Inkonsistenzen und Ausreißern, welche die Ergebnisse von KI-Modellen verfälschen können. Wenn Organisationen sicherstellen, dass nur saubere und vertrauenswürdige Daten in KI-Initiativen verwendet werden, können sie die Zuverlässigkeit und Leistungsfähigkeit ihrer Modelle verbessern.

💡Was Zeenea unterscheidet: Zeenea verwendet die GraphQL-Technologie und seinen Knowledge Graph, um einen flexiblen Ansatz für die Integration der marktführenden Lösungen für das Datenqualitätsmanagement direkt im Katalog zu bieten. Einfache Synchronisation der Datenqualitätsindikatoren Ihrer Drittanbieter-Tools über einfache API-Abfragen. Die Fähigkeiten unserer Katalog-API ermöglichen die automatische Aktualisierung aller Änderungen, die in Ihrem DQM-Tool vorgenommen werden, direkt auf unserer Plattform.

Entdecken Sie unsere Datenqualitätsfunktionen.

Verbesserung der Data Governance und der Compliance

Die Data Governance ist entscheidend für die Aufrechterhaltung der Integrität, der Sicherheit und der Einhaltung der gesetzlichen Vorschriften. Sie beinhaltet Prozesse, Richtlinien und Standards, die sicherstellen, dass Daten während ihres gesamten Lebenszyklus korrekt verwaltet und verwendet werden. Vorschriften wie die DSGVO in Europa und CCPA in Kalifornien, USA, sind Beispiele für strenge Gesetze, die von den Unternehmen eingehalten werden müssen.

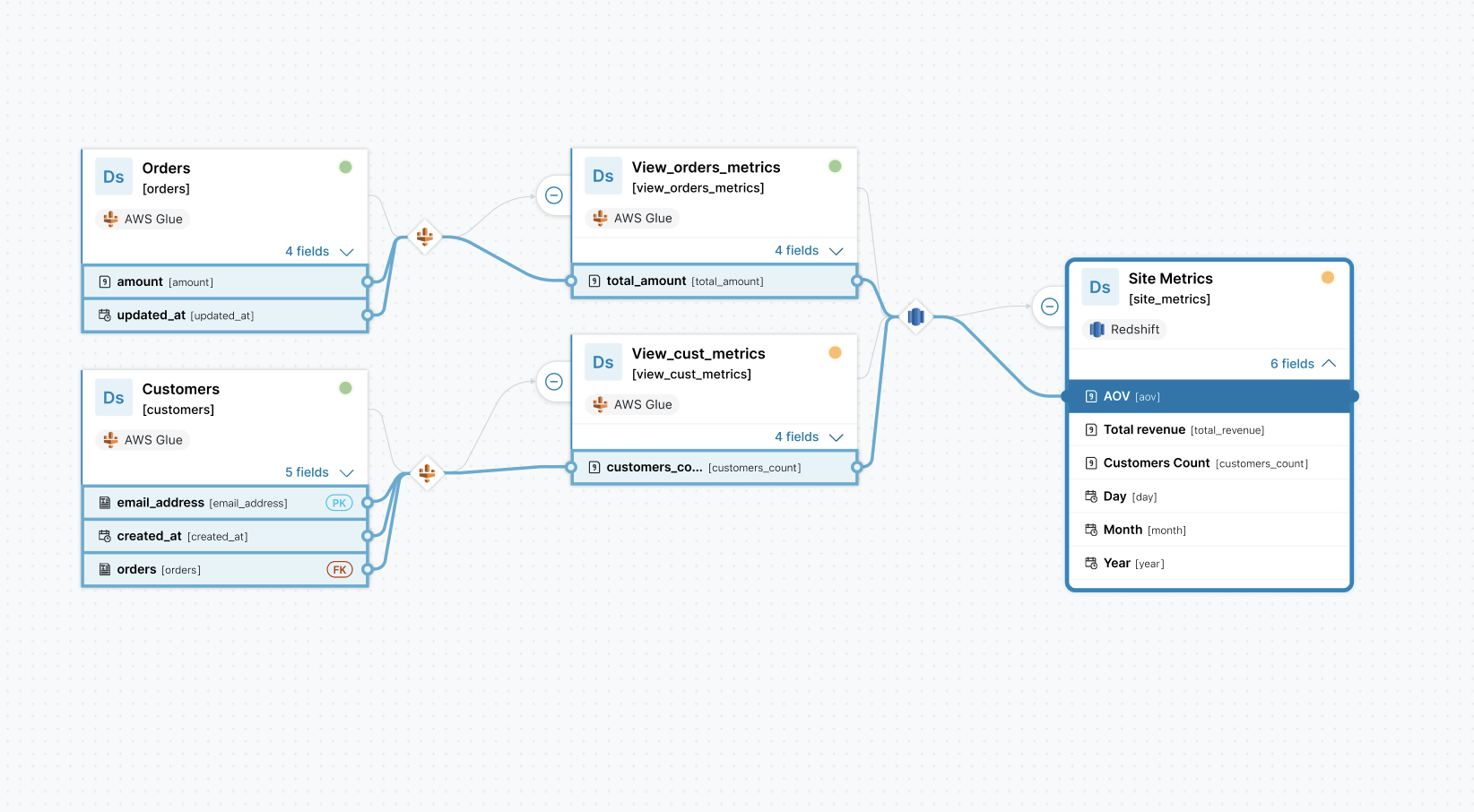

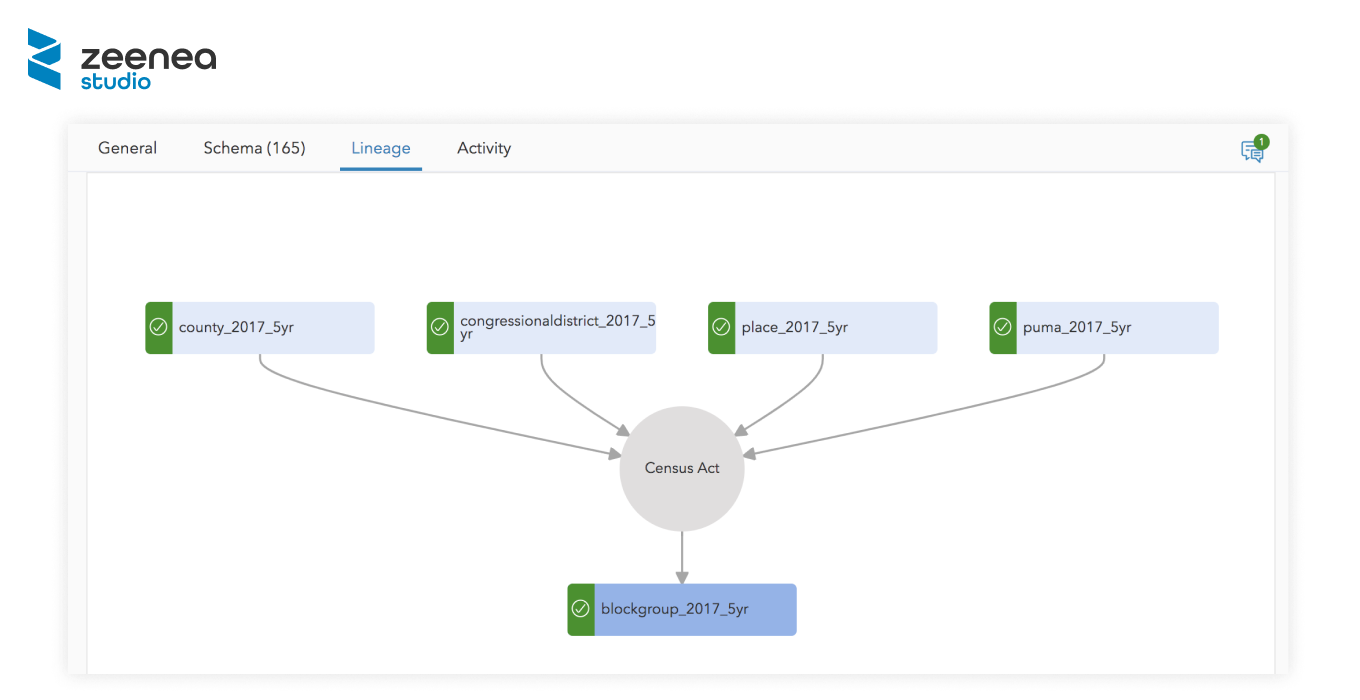

Darüber hinaus fördert die Data Governance die Transparenz, Rechenschaftspflicht und Rückverfolgbarkeit von Daten und erleichtert es den Beteiligten, Fehler zu erkennen und die mit fehlerhaften oder falsch dargestellten KI-Insights verbundenen Risiken zu verringern, bevor sie sich negativ auf den Betrieb auswirken oder den Ruf der Organisation schädigen können. Datenkataloge unterstützen diese Governance-Initiativen, indem sie detaillierte Metadaten bereitstellen, einschließlich der Data Lineage, dem Ownership und der Nutzungsrichtlinien.

Für KI-Initiativen bedeutet eine robuste Data Governance, dass die Daten auf verantwortungsvolle und ethische Weise genutzt werden können, wodurch das Risiko von Missbrauch und Non-Compliance minimiert wird. Das schützt das Unternehmen rechtlich und ethisch, stärkt das Vertrauen von Kunden und Stakeholdern und stellt sicher, dass KI-Initiativen nachhaltig und glaubwürdig sind.

💡Was Zeenea unterscheidet: Zeenea gewährleistet die Einhaltung aller gesetzlichen Vorschriften durch die automatische Identifizierung, Klassifizierung und unternehmensweite Verwaltung personenbezogener Datenbestände. Mithilfe intelligenter Empfehlungen erkennt die Plattform persönliche Daten und macht Vorschläge, welche Objekte getaggt werden sollten. Dabei stellt sie sicher, dass die Informationen über Datenschutzrichtlinien und -vorschriften allen Datenkonsumenten innerhalb des Unternehmens bei ihrer täglichen Arbeit bekannt gemacht werden.

Entdecken Sie unsere Data-Governance-Funktionen.

Zusammenarbeit und Wissensaustausch

An KI-Projekten sind häufig funktionsübergreifende Teams mit Data Scientists, Engineers, Analysten und Geschäftsfunktionen beteiligt. Datenkataloge spielen eine Schlüsselrolle bei der Förderung der Zusammenarbeit, da sie als gemeinsame Plattform dienen, auf der die Teammitglieder Datenbestände dokumentieren, teilen und diskutieren können. Funktionen wie Annotationen, Kommentare und Datenbewertungen ermöglichen es den Benutzern, ihre Erkenntnisse und ihr Wissen direkt in den Datenkatalog einzubringen. Diese Funktion fördert eine kollaborative Umgebung, in der die Beteiligten Ideen austauschen und bei datenbezogenen Aufgaben iterativ vorgehen können.

Beispielsweise können Data Scientists Datensätze mit Qualitätsinformationen oder spezifischen Merkmalen annotieren, die für Machine-Learning-Modelle nützlich sind. Engineers können Kommentare zu Anforderungen an die Datenintegration oder zu technischen Überlegungen hinterlassen. Analysten können die Relevanz oder Nützlichkeit verschiedener Datensätze entsprechend ihren analytischen Anforderungen bewerten.

💡Was Zeenea unterscheidet: Zeenea bietet Chat-Tabs für jedes Objekt im Katalog und erleichtert so die effektive Kommunikation zwischen Data Stewards und Datenkonsumenten über ihre Assets. Bald werden die Datenkonsumenten auch Vorschläge zum Inhalt ihrer Objekte machen können, was eine kontinuierliche Verbesserung und die Aufrechterhaltung der höchsten Qualität der Datendokumentation innerhalb des Katalogs gewährleistet.

Ein unternehmensweites einheitliches Verständnis von KI-Begriffen

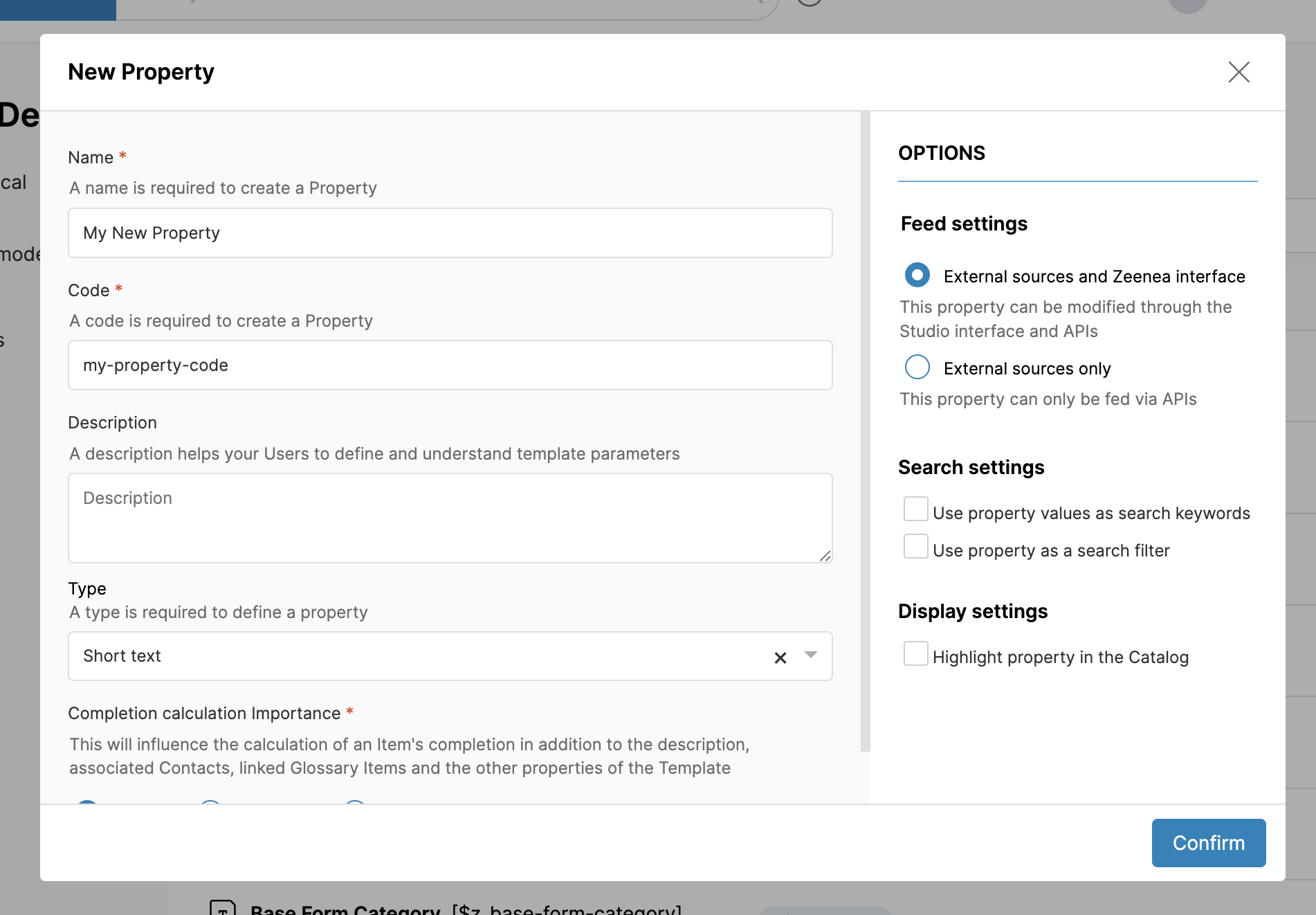

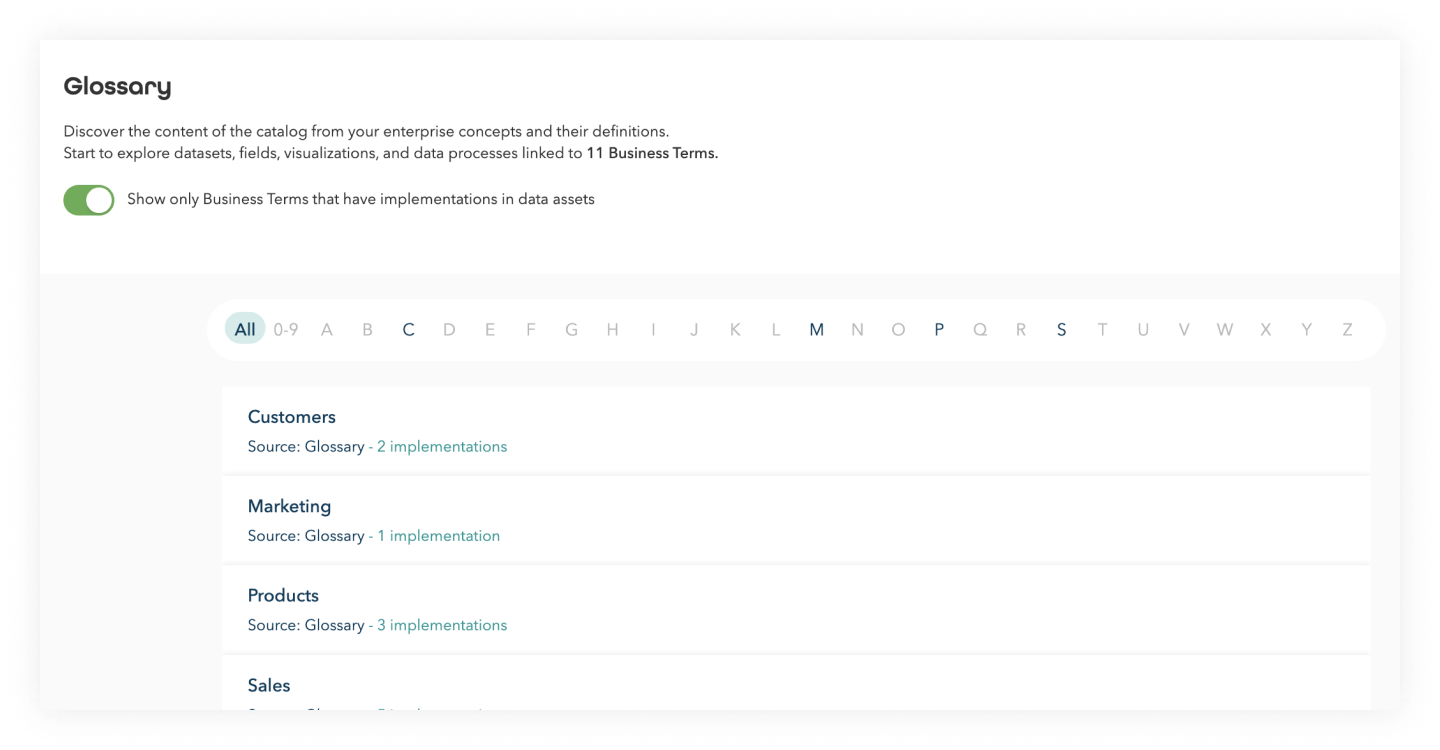

Datenkataloge beinhalten oft ein Business Glossary, ein zentrales Repository zur Definition und Standardisierung von geschäftlichen Fachbegriffen und Definitionen von Daten und KI in einer Organisation. Ein Business Glossary verbessert die Abstimmung zwischen den Business-Stakeholdern und den Datenmanagern, indem es klare Definitionen festlegt und die Konsistenz der Terminologie gewährleistet.

Diese Klarheit ist entscheidend für KI-Initiativen, bei denen ein genaues Verständnis und eine genaue Interpretation der Daten für die Entwicklung präziser Modelle von entscheidender Bedeutung ist. Mithilfe eines gut definierten Business Glossarys können Data Scientists die richtigen Datensätze schnell identifizieren und zum Trainieren von KI-Modellen verwenden, wodurch die Zeit für die Datenvorbereitung reduziert und die Produktivität gesteigert wird. Da ein Business Glossary ein gemeinsames und abteilungsübergreifenden Verständnis für Daten fördert, beschleunigt es die Entwicklungszyklen von KI-Projekten und ermöglicht es Unternehmen, aus ihrem Datenbestand aussagekräftige Erkenntnisse zu gewinnen.

💡Was Zeenea unterscheidet: Zeenea bietet Datenmanagement-Teams eine einzigartige Unterstützung, um ihre Kategorien semantischer Konzepte zu erstellen, sie in Hierarchien zu organisieren und zu konfigurieren, wie Glossarobjekte mit technischen Assets verknüpft werden.

Entdecken Sie unsere Business-Glossary-Funktionen.

Schlussfolgerung

Angesichts der sich ständig verändernden Datenlandschaft und der Zunahme KI-gestützter Entscheidungsprozesse sind Datenkataloge zu unverzichtbaren Werkzeugen für Unternehmen geworden, die ihre Datenbestände effektiv nutzen wollen. Datenkataloge stellen sicher, dass KI-Initiativen auf qualitativ hochwertigen, gut verwalteten und gut dokumentierten Daten aufbauen. Eine wichtige Grundlage, um genaue Trends zu erhalten und einen nachhaltigen Mehrwert für das Unternehmen zu schaffen.

Da die Unternehmen weiterhin massiv in KI-bezogene Fähigkeiten investieren, wird die Einführung eines robusten Datenkatalogs eine Schlüsselrolle spielen, um den Wert der Datenbestände zu maximieren, Innovationen voranzutreiben und einen Wettbewerbsvorteil zu erhalten.

![[SERIE] Data Shopping Teil 2 – Das Data-Shopping-Erlebnis in Zeenea](https://zeenea.com/wp-content/uploads/2024/06/zeenea-data-shopping-experience-blog-image-1080x675.png)

![[SERIE] Der Data Marketplace für das Data Mesh – Teil 3: Den Marketplace über domänenspezifische Datenkataloge mit Inhalten versorgen](https://zeenea.com/wp-content/uploads/2024/06/iStock-1418478531-1080x675.jpg)

![[SERIE] Der Data Marketplace für das Data Mesh – Teil 2: Einen unternehmensweiten Marketplace aufbauen](https://zeenea.com/wp-content/uploads/2024/06/iStock-1513818710-1080x675.jpg)

![[SERIE] Der Data Marketplace für das Data Mesh – Teil 1: Die Nutzung von Datenprodukten mit Metadaten erleichtern](https://zeenea.com/wp-content/uploads/2024/05/iStock-1485944683-1080x675.jpg)