![[SERIE] Data Shopping Teil 2 – Das Data-Shopping-Erlebnis in Zeenea](https://zeenea.com/wp-content/uploads/2024/06/zeenea-data-shopping-experience-blog-image-1080x675.png)

[SERIE] Data Shopping Teil 2 – Das Data-Shopping-Erlebnis in Zeenea

Der Prozess der Datennutzung in Unternehmen hat sich auf ähnliche Weise entwickelt wie der Kauf von Waren im Internet, wo der Konsument Gegenstände aussucht, sie in den Warenkorb legt und Liefer- und Zahlungsoptionen auswählt. Im Zeitalter von Data Products und Data Mesh ermöglichen interne Data Marketplaces den Fachanwendern, Daten für ihre Anwendungsfälle zu suchen, zu finden und auf sie zuzugreifen.

In dieser Artikelreihe finden Sie einen Auszug aus unserem Praxisleitfaden Data Mesh und erfahren alles Wissenswerte über das Data Shopping, das Data-Shopping-Erlebnis mit Zeenea und über unseren Enterprise Data Marketplace:

- Der Konsum von Data Products

- Das Data-Shopping-Erlebnis mit Zeenea

—

In unserem vorherigen Artikel haben wir uns mit dem Konzept des Data Shoppings auf einem internen Data Marketplace befasst und dabei Elemente wie die Lieferung von Datenprodukten und die Zugriffsverwaltung behandelt. In diesem Artikel werden wir die Gründe näher betrachten, die Zeenea dazu veranlasst haben, sein Data-Shopping-Erlebnis über die internen Grenzen hinaus auszuweiten. Außerdem erfahren Sie, wie unsere Schnittstelle, Zeenea Studio, die Analyse der Gesamtleistung Ihrer Data Products ermöglicht.

Datenprodukt-Shopping mit Zeenea

In unserem letzten Artikel haben wir die Komplexität der Verwaltung von Zugriffsrechten auf Datenprodukte aufgrund der mit dem Datenverbrauch verbundenen Risiken behandelt. In einem dezentralen Data Mesh bewertet der Eigentümer des Data Products die Risiken, gewährt den Zugriff und wendet Richtlinien an, welche die Sensibilität der Daten, die Rolle, den Standort und das Ziel des Antragstellers berücksichtigen. Dies kann eine Transformation der Daten oder zusätzliche Formalitäten nach sich ziehen, wobei die Lieferung von schreibgeschütztem Zugriff bis hin zu granularen Kontrollen reichen kann.

Auf einem Data Marketplace lösen Konsumenten einen Workflow aus, indem sie Zugriffsanfragen stellen, die von den Dateneigentümern bewertet werden und für die sie die Zugriffsregeln festlegen, manchmal mithilfe einer Expertenmeinung. Für den Zeenea-Marketplace haben wir uns dafür entschieden, diesen Workflow nicht direkt in die Lösung zu integrieren, sondern stattdessen Schnittstellen zu externen Lösungen zu nutzen.

Die Idee dahinter ist, ein einheitliches Erlebnis zum Auslösen einer Zugriffsanfrage zu bieten, aber gleichzeitig anzuerkennen, dass die Bearbeitung dieser Anfrage in verschiedenen Umgebungen oder sogar in verschiedenen Domänen innerhalb derselben Organisation sehr unterschiedlich sein kann. Auch hier haben wir das Prinzip von klassischen Marktplätzen übernommen. Die meisten bieten ein einheitliches Erlebnis, um eine Bestellung abzuschließen, greifen aber für die operative Umsetzung der Lieferung – die je nach Produkt und Verkäufer sehr unterschiedlich gestaltet sein kann – auf andere Lösungen zurück.

Diese Entkoppelung von Einkaufserlebnis und operativer Umsetzung der Lieferung erscheint uns aus mehreren Gründen unerlässlich.

Vor allem aufgrund der extremen Variabilität der beteiligten Prozesse. Einige Unternehmen verfügen bereits über operative Workflows, die auf einer breiteren Lösung aufbauen (die Datenzugriffsanfrage ist in einen allgemeinen Prozess zur Beantragung von Zugriffsrechten eingebettet, der z. B. durch ein Ticketing-Tool wie ServiceNow oder Jira unterstützt wird). Andere sind mit speziellen Lösungen ausgestattet, die einen hohen Automatisierungsgrad unterstützen, aber noch nicht flächendeckend eingesetzt werden. Andere verlassen sich auf die Fähigkeiten ihrer Datenplattform, wieder andere auf gar nichts – der Zugang erfolgt über direkte Anfragen an den Dateneigentümer, der die Daten ohne formellen Prozess verarbeitet. Diese Variabilität zeigt sich zwischen Unternehmen, aber auch innerhalb einer Organisation – strukturell, wenn verschiedene Domänen unterschiedliche Technologien verwenden, oder zeitlich, wenn die Organisation beschließt, in ein Produkt zu investieren, das mehr Effizienz oder Sicherheit bietet, und die Zugriffsverwaltung schrittweise auf dieses neue Produkt migriert werden muss.

Dank dieser Entkoppelung ist es also ermöglich, dem Konsumenten ein einheitliches Erlebnis zu bieten und gleichzeitig die Variabilität der Arbeitsweisen anzuerkennen.

Für den Kunden ist das Einkaufserlebnis auf dem Data Marketplace also sehr einfach. Sobald er das oder die passenden Datenprodukte identifiziert hat, löst er eine Zugriffsanfrage aus und stellt die folgenden Informationen bereit:

- Wer er ist – diese Information ist im Prinzip bereits verfügbar.

- Auf welches Data Product er zugreifen möchte – auch hier sind die Informationen bereits vorhanden, ebenso wie die Metadaten, die für die Durchführung von Abwägungen benötigt werden.

- Wie er die Daten nutzen will – dieser Punkt ist von grundlegender Bedeutung, da er das Risikomanagement und die Anforderungen an die Compliance betrifft.

Bei Zeenea wird die eingegangene Zugriffsanfrage in einem anderen System verarbeitet, und ihr Status kann vom Marketplace aus verfolgt werden – das ist das exakte Pendant zur Auftragsverfolgung, wie man sie von E-Commerce-Websites kennt.

Aus der Sicht des Konsumenten bietet der Data Marketplace einen Katalog von Datenprodukten (und anderen digitalen Produkten) sowie ein einfaches und einheitliches System, um Zugang zu diesen Produkten zu erhalten.

Für den Produzenten erfüllt der Data Marketplace eine wichtige Rolle bei der Steuerung seines Produktportfolios.

Verbessern Sie die Leistung von Data Products mit Zeenea Studio

Wie bereits erwähnt, bietet ein klassischer Marktplatz neben dem E-Commerce-System, das sich an die Verbraucher richtet, auch spezielle Tools für Verkäufer, mit denen sie ihre Produkte überwachen, auf Anfragen von Käufern reagieren und die wirtschaftliche Leistung ihres Angebots kontrollieren können. Außerdem enthalten sie weitere Tools für Marktplatz-Manager, um die Gesamtleistung von Produkten und Verkäufern zu analysieren.

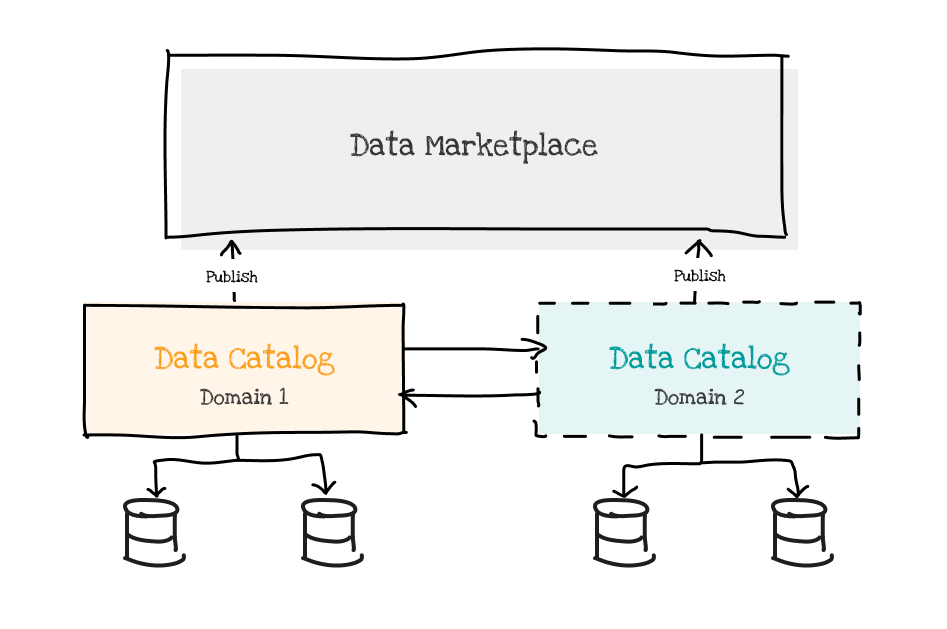

Der Enterprise Data Marketplace von Zeenea integriert diese Fähigkeiten in ein spezielles Backoffice-Tool, Zeenea Studio. Mit seiner Hilfe können Sie die Erstellung, Konsolidierung und Organisation von Metadaten in einem privaten Katalog verwalten und entscheiden, welche Objekte auf dem Marketplace – einem für die breite Öffentlichkeit zugänglichen Bereich – angeboten werden.

Diese Aktivitäten gehören in erster Linie zum Produktionsprozess – Metadaten werden gemeinsam mit den Datenprodukten produziert und organisiert. Das Tool ermöglicht aber auch die Überwachung der Nutzung jedes einzelnen Datenprodukts, insbesondere durch die Bereitstellung einer Liste aller Konsumenten und der ihnen zugeordneten Nutzungsarten.

Mit dieser Überwachung der Konsumenten ist es möglich, die beiden Säulen der Data-Mesh-Governance fest im System zu verankern:

- Compliance und Risikomanagement – durch die Einführung regelmäßiger Überprüfungen, Zertifizierungen und Folgenabschätzungen bei der Weiterentwicklung von Datenprodukten.

- Performance-Steuerung – die Anzahl der Konsumenten sowie die Nutzungsarten sind die wichtigsten Indikatoren für den Wert eines Data Products. Denn ein Datenprodukt, das nicht genutzt wird, hat keinen Wert.

Der Enterprise Data Marketplace von Zeenea unterstützt die Unternehmensbereiche bei der Überwachung der Compliance und Performance ihrer Produkte und bietet auch die Möglichkeit einer umfassenden Mesh-Analyse – Lineage, Scoring und Leistungsbewertung von Data Products, Überwachung der globalen Compliance und der Risiken, Elemente für die Berichterstattung an Behörden usw.

Das ist die Magie des Federated Graphs, der es ermöglicht, Informationen auf allen Ebenen zu nutzen – und eine umfassende Darstellung des gesamten Datenbestands liefert.

Praxisleitfaden Data Mesh: Ein unternehmensweites Data Mesh einrichten und überwachen

Dieser Leitfaden von Guillaume Bodet, Mitbegründer und CPTO von Zeenea, vermittelt Ihnen einen praktischen Ansatz zur Implementierung eines Data Mesh in Ihrer Organisation und hilft Ihnen:

✅ Ihren Data-Mesh-Ansatz mit einem fokussierten Pilotprojekt zu starten,

✅ effektive Methoden kennenzulernen, um Ihr Data Mesh zu skalieren,

✅ die entscheidende Rolle eines internen Data Marketplaces zu verstehen, um die Nutzung von Datenprodukten zu erleichtern

✅ zu verstehen, was Zeenea als robustes, unternehmensweites Data-Mesh-Monitoring-System auszeichnet.

![[SERIE] Der Data Marketplace für das Data Mesh – Teil 3: Den Marketplace über domänenspezifische Datenkataloge mit Inhalten versorgen](https://zeenea.com/wp-content/uploads/2024/06/iStock-1418478531-1080x675.jpg)

![[SERIE] Der Data Marketplace für das Data Mesh – Teil 2: Einen unternehmensweiten Marketplace aufbauen](https://zeenea.com/wp-content/uploads/2024/06/iStock-1513818710-1080x675.jpg)

![[SERIE] Der Data Marketplace für das Data Mesh – Teil 1: Die Nutzung von Datenprodukten mit Metadaten erleichtern](https://zeenea.com/wp-content/uploads/2024/05/iStock-1485944683-1080x675.jpg)