Les priorités et défis majeurs du Chief Data Officer (CDO) en 2024

Dans le monde dynamique des affaires modernes, la collecte, la transformation et l’utilisation des données sont devenues indispensables pour les organisations cherchant à maintenir un avantage concurrentiel. La volonté de devenir plus “data-centric” est évidente dans toutes les industries, et de nombreuses organisations nomment des Chief Data Officers (CDO) pour les guider vers un avenir où des informations précieuses sont rapidement découvertes et exploitées. Au cours de l’été 2023, AWS a mené une étude mondiale approfondie sur l’évolution du rôle des CDO, leurs principales priorités et les défis auxquels ils ont été confrontés en 2023.

Dans cet article, nous allons analyser les principales conclusions de cette étude et nous intéresser aux sujets majeurs sur lesquels les CDO vont se concentrer en 2024.

L’IA générative, une tendance à venir ?

Une approche enthousiaste du potentiel de l’IA générative

Alors que l’adoption de l’IA générative n’en est qu’à ses débuts, les CDO de tous les secteurs d’activité explorent activement ses possibilités. L’IA générative suscite beaucoup d’enthousiasme, certains CDO exprimant la façon dont elle a revalorisé leur statut au sein de leur organisation. Cependant, l’étude révèle que, pour l’instant, l’utilisation de l’IA générative est largement expérimentale pour de nombreuses organisations. Près d’un tiers des personnes interrogées ont indiqué qu’elles « expérimentaient au niveau individuel », sans stratégie d’entreprise globale.

Malgré la nature exploratoire actuelle des initiatives d’IA générative, les CDO envisagent un avenir transformateur. Ce sont pas moins de 80 % des personnes interrogées qui pensent que l’IA générative transformera à terme les activités de leur organisation. En outre, 46 % prévoient ou constatent déjà une adoption généralisée de l’IA générative au sein de leur organisation et 62 % prévoient d’augmenter leurs investissements dans l’IA générative.

La qualité des données, la confiance et la sécurité sont les plus grands défis de l’IA générative

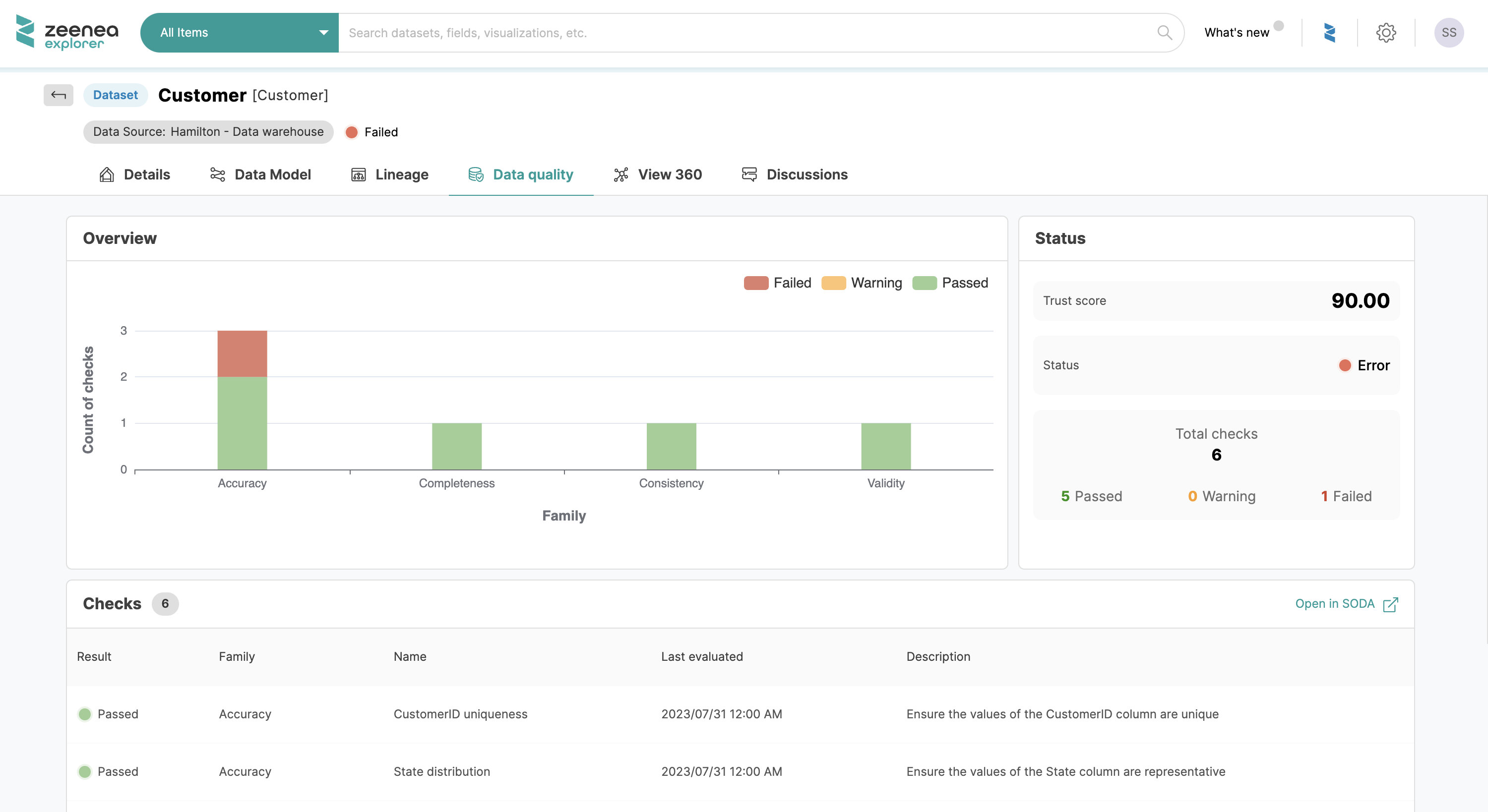

Cependant, un pourcentage important de CDO a désigné la qualité des données comme le principal défi de l’IA générative. Le rôle fondamental des données de haute qualité dans l’entraînement des modèles d’IA générative ne peut être surestimé, et trouver les bons cas d’usage est essentiel pour générer des perspectives et une valeur significatives.

L’établissement de barrières pour une utilisation responsable est également apparu comme une préoccupation, car 43 % des CDO reconnaissent la nécessité de pratiques éthiques et responsables en matière d’IA. La sécurité et la confidentialité des données suivent de près, ainsi que la connaissance et la maîtrise des données, soulignant le besoin d’une main-d’œuvre capable d’exploiter la puissance de l’IA générative.

La gouvernance des données reste une priorité

Les entreprises changent d’approche en matière de gouvernance des données

Pour la deuxième année consécutive, la gouvernance des données s’est imposée comme la principale activité consommatrice du temps des CDO, reflétant une croissance de 44 % en 2022 à 63 % en 2023. En outre, plus de la moitié des CDO (51 %) considèrent la gouvernance des données comme une responsabilité de premier plan, 66 % indiquant qu’elle consomme au moins 20 % de leur temps.

Le rapport AWS souligne que les objectifs de la gouvernance des données consistent à garantir la disponibilité des données, à renforcer la confiance et à assurer la protection des données. Sans une solide composante de gouvernance des données, aucune stratégie data ne peut être exécutée efficacement – la gouvernance des données est considérée comme le premier levier de création de valeur pour les CDO.

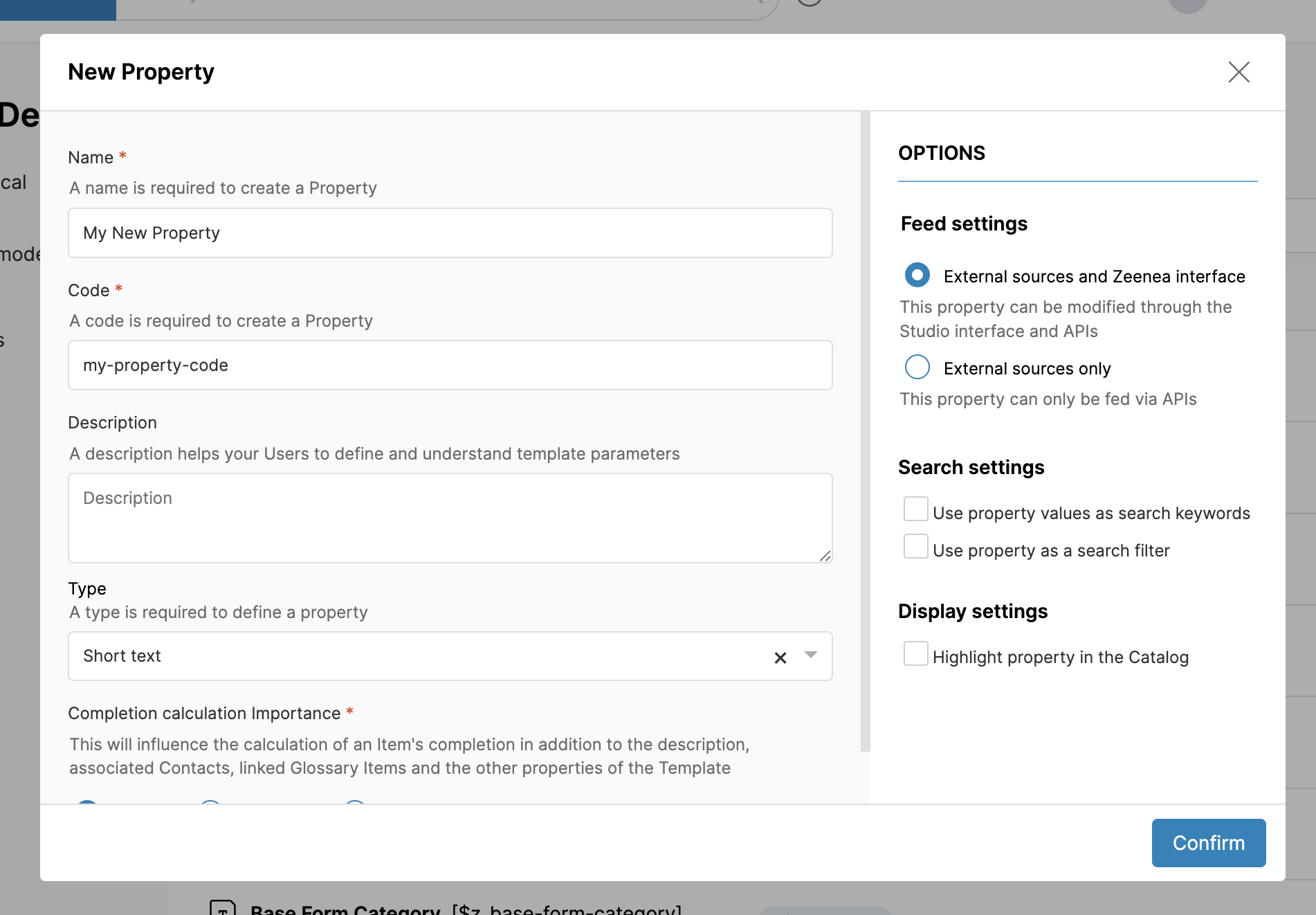

Les CDO reconnaissent que la mise en place d’une gouvernance des données efficace est un défi, principalement en raison des changements de comportement significatifs qu’elle nécessite au sein des organisations. Le concept traditionnel de « gouvernance » est en train de se transformer dans certaines entreprises, avec une évolution positive vers “l’activation des données« . Ce changement de terminologie reflète une évolution qui positionne la gouvernance des données comme un catalyseur plutôt que comme une mesure restrictive.

La culture et la maîtrise des données restent un défi pour une utilisation efficace

Selon le rapport, la création d’une culture data-driven est le principal défi à relever. L’enquête met en évidence les multiples facettes de ce défi, qui englobe les comportements organisationnels, les attitudes et l’absence d’une culture axée sur les données ou d’une approche de la prise de décision. Les CDO s’efforcent d’inculquer un état d’esprit centré sur les données au sein de leur organisation, en rencontrant divers obstacles au cours du processus :

- Difficulté à changer les comportements et les attitudes au sein de l’organisation (70 %)

- Absence d’une culture ou d’une prise de décision axée sur les données (59 %)

- Manque de maîtrise ou de compréhension des données (50 %)

- Ressources insuffisantes pour atteindre les objectifs (55%)

Pour relever ces défis, les CDO s’engagent activement dans des initiatives d’acculturation data, plus de la moitié d’entre eux consacrant un cinquième de leur temps ou plus à ces programmes. Ces initiatives comprennent souvent des programmes de maîtrise des données et des approches de gestion du changement adaptées à des projets spécifiques data ou analytiques.

Création de valeur commerciale visible

L’analytique et l’IA dans le développement de projets

En 2022, les projets d’analytique et d’IA étaient reconnus comme cruciaux pour apporter une valeur mesurable, un sentiment qui n’a fait que se renforcer en 2023. Plus de la moitié des répondants privilégient désormais une approche ciblée, en se concentrant sur un petit ensemble de projets clés d’analytique ou d’IA comme principale source de création de valeur.

Bien que la gestion des données soit une responsabilité primordiale, 44 % des CDO mettent l’accent sur les initiatives de gestion des données, telles que l’amélioration de l’infrastructure, dans le contexte spécifique de chaque cas d’usage analytique et IA, plutôt que comme un effort autonome.

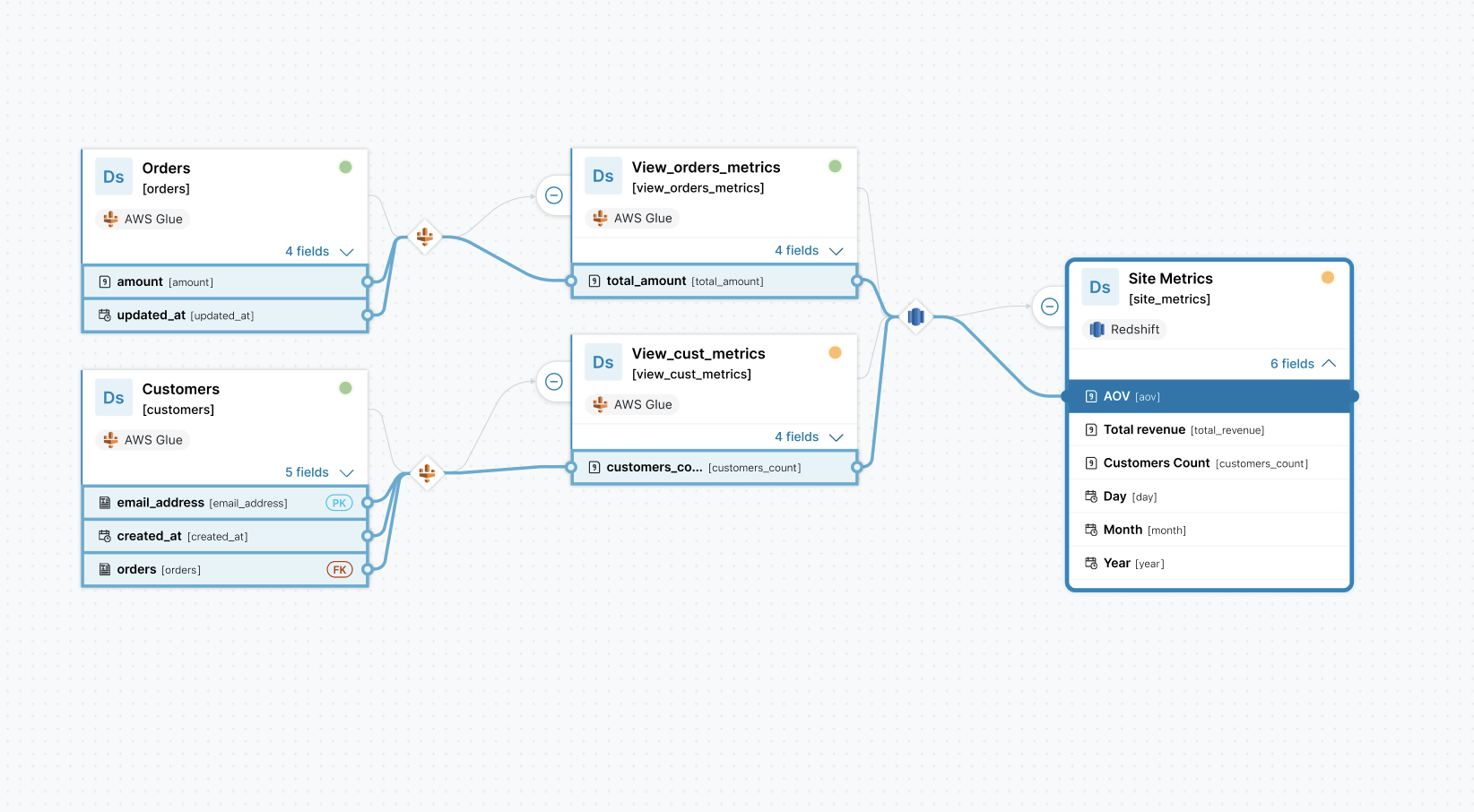

Vers une approche axée sur les produits de données

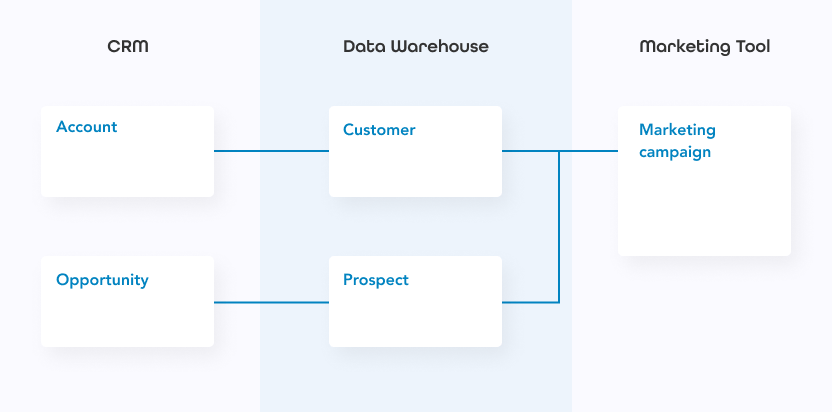

Le concept de produits de données (data products), né avec le Data Mesh, représente une nouvelle approche de la gestion des données. Fondé sur le principe du traitement des données comme un produit, ce concept innovant introduit un ensemble de caractéristiques qui redéfinissent la façon dont les organisations perçoivent et exploitent leurs actifs de données.

Selon l’étude, 39 % des CDO adoptent une orientation de gestion des produits de données et intègrent dans leurs équipes des data product managers dédiés. Cette approche garantit une gestion complète et disciplinée de toutes les facettes des initiatives analytiques ou IA, de la conception au déploiement et à la maintenance continue.

Dans le rapport, Sebastian Klapdor, Chief Data and Technology chez Vista, déclare : « L’accent mis sur les data products a permis de rapprocher les experts data du reste de l’organisation. Désormais, les responsables des produits de données commenceront à suivre la même méthode de travail que les products managers qui développent des logiciels destinés aux clients ».

En conclusion

Le paysage des CDO en 2024 est façonné par des défis dynamiques et des priorités en constante évolution, comme le révèle le CDO Agenda 2024 d’AWS. L’exploration de l’IA générative montre à la fois l’excitation et la prudence des CDO – alors que le potentiel de transformation est largement reconnu, des défis tels que la qualité des données, les considérations éthiques et la sécurité soulignent la nécessité d’une approche équilibrée et responsable.

En outre, la gouvernance des données reste une préoccupation constante, avec une perspective changeante vers « l’activation des données » et la lutte continue pour instiller une culture axée sur les données au sein des organisations.

Enfin, la recherche d’une création de valeur commerciale visible met l’accent sur une évolution vers une approche de produit de données et une intégration stratégique de l’analytique et de l’IA dans le développement de projets. Les CDO ne se contentent pas de naviguer dans les avancées technologiques, ils s’attaquent aussi activement aux changements culturels et organisationnels nécessaires pour exploiter tout le potentiel des données.